Оглавление

- Почему именно GPU-VPS для Stable Diffusion

- Подготовка окружения: установка NVIDIA-драйверов и CUDA

- Установка Python 3.10 и настройка виртуального окружения

- Установка Stable Diffusion WebUI (AUTOMATIC1111)

- Загрузка модели Stable Diffusion (weights)

- Запуск веб-интерфейса и первая генерация

- Итоги и новые горизонты

Введение

Представьте: вы описываете сцену словами – и нейросеть рисует её для вас. Звучит как магия? С моделью Stable Diffusion это реальность. Однако чтобы укротить этого «художника», нужен серьёзный двигатель – мощная видеокарта. Здесь на помощь приходят облачные GPU‑VPS. В этом практическом гайде мы шаг за шагом покажем, как развернуть Stable Diffusion на удалённом сервере с GPU (на примере King Servers с видеокартами RTX A4000, A5000, A6000 или GeForce RTX 3090) под Ubuntu 20.04. Вас ждёт дружелюбное и понятное руководство: от установки драйверов до генерации первых изображений через веб-интерфейс. Приготовьтесь превратить свой сервер в фабрику воображения!

Почему именно GPU-VPS для Stable Diffusion

Stable Diffusion – мощная модель генерации изображений, способная творить чудеса по текстовому описанию. Но её «волшебство» требует вычислительных ресурсов, особенно видеокарты с большим объёмом памяти. Без GPU такая модель будет работать черепашьими темпами либо вовсе не запустится. Покупать собственную топовую видеокарту ради экспериментов дорого: профессиональные GPU стоят тысячи долларов (например, даже «скромная» NVIDIA RTX A6000 обойдётся в целое состояние). К счастью, аренда GPU-сервера решает проблему.

GPU-VPS от King Servers – идеальная платформа для таких задач. Вы получаете удалённый сервер с мощной видеокартой профессионального уровня (в парке доступна серия Nvidia RTX: A4000, A5000, A6000, а также GeForce 30×0). Это значит, что под ваши проекты доступна видеопамять от 16 ГБ до 48 ГБ – с таким запасом Stable Diffusion чувствует себя свободно и не сталкивается с ошибками Out of Memory. Вам не нужно тратить тысячи долларов сразу – вы платите помесячно за нужные ресурсы, снижая порог входа практически до нуля. При этом легко масштабироваться: сегодня нужен один GPU – вы арендуете один сервер, завтра проект вырос – добавляете ещё. Закончили эксперимент – отключили лишние мощности и не платите за простой. Всё гибко и выгодно. Кроме того, такие серверы размещены в надёжных дата-центрах (King Servers предлагает площадки в Европе, США и России) – никакого перегрева под столом и 24/7 поддержка на случай, если нужна помощь в настройке. В итоге вы получаете полный контроль над мощной машиной без хлопот владения железом. Звучит неплохо, верно? Тогда давайте настроим такой сервер под Stable Diffusion!

Подготовка окружения: установка NVIDIA-драйверов и CUDA

Первым делом научим наш сервер распознавать графический процессор. Представьте, что GPU-драйвер – это «язык», на котором система общается с видеокартой. Без него даже самый мощный RTX A5000 – просто молчащий кусок кремния.

1. Установка драйверов NVIDIA. В Ubuntu Server нет графического интерфейса, поэтому всё делаем в терминале (SSH). Обновим систему и установим драйвер автоматически командой:

sudo apt update && sudo apt upgrade -y

sudo ubuntu-drivers autoinstall

sudo reboot

Эта команда сама выберет и установит рекомендуемый проприетарный драйвер NVIDIA для вашей карты. Если система найдёт несколько вариантов, она возьмёт последний стабильный (как правило, чем выше номер версии драйвера, тем новее и лучше поддержка GPU). Установка может занять пару минут. По окончании перезагрузите сервер для активации драйверов:

sudo reboot

После перезапуска снова подключитесь к серверу по SSH. Теперь проверим, увидела ли система видеокарту – выполните команду мониторинга NVIDIA:

nvidia-smi

Если драйвер встал успешно, вы увидите таблицу с информацией: версией драйвера, моделью GPU и статистикой загрузки. Например, для RTX 3090 вывод покажет что-то вроде:

Поздравляем – сервер «научился» работать с вашей видеокартой. 🎉

2. Установка CUDA. Теперь, когда драйвер есть, базовые CUDA-рантайм-библиотеки уже включены (их устанавливает драйвер). Этого достаточно, чтобы запускать нейросети. Но если вы планируете компилировать что-то под GPU или просто хотите иметь инструменты CUDA, установим пакет CUDA Toolkit:

sudo apt install -y nvidia-cuda-toolkit

Эта команда загрузит набор инструментов CUDA из репозиториев Ubuntu. Размер немаленький, придётся подождать. По завершении в системе появится утилита nvcc (CUDA compiler) и прочие инструменты. Примечание: строжайшей необходимости в полном CUDA Toolkit для Stable Diffusion нет – модель прекрасно запустится и без него, но наличие CUDA лишним не бывает, особенно если вы решите экспериментировать с другими AI-библиотеками.

Установка Python 3.10 и настройка виртуального окружения

Stable Diffusion работает на Python, поэтому нам нужен правильный Python и изолированное окружение для установки зависимостей. Ubuntu 20.04 поставляется с Python 3.8, но новейшие версии Stable Diffusion требуют Python 3.10 для совместимости с современными библиотеками (PyTorch, Transformers и пр.). Давайте установим Python 3.10 рядом с системой (не удаляя старый).

1. Установка Python 3.10. Воспользуемся репозиторием deadsnakes, где энтузиасты собирают свежие версии Python для Ubuntu. Выполните по шагам:

sudo apt install -y software-properties-common

sudo add-apt-repository -y ppa:deadsnakes/ppa

sudo apt update

sudo apt install -y python3.10 python3.10-venv

Первая команда установит утилиту для работы с PPA-репозиториями, вторая – добавит источник с Python 3.10, третья обновит список пакетов, а четвёртая установит сам Python 3.10 и модуль venv для создания виртуальных окружений. Когда появится запрос подтверждения добавления PPA, нажмите Enter – это официальный проверенный источник. После установки проверьте версию:

python3.10 --version

Терминал должен ответить Python 3.10.x. Отлично, нужный интерпретатор готов.

2. Настройка виртуального окружения. Виртуальное окружение Python – это как изолированная «песочница», где будут установлены все библиотеки для Stable Diffusion, не влияя на системные. Это лучшая практика: когда захотим убрать всё – просто удалим папку окружения.

Создадим новое окружение (назовём его, например, sd_env) с помощью только что установленного Python 3.10:

python3.10 -m venv ~/sd_env

Команда создаст папку sd_env в вашем домашнем каталоге (~). Теперь активируем окружение:

source ~/sd_env/bin/activate

После активации вы увидите в начале приглашения терминала префикс (sd_env) – это знак, что вы «находитесь» внутри виртуального окружения. Теперь все пакеты, которые мы установим через pip, лягут внутрь sd_env, и система вне его их не «увидит».

source ~/sd_env/bin/activate, чтобы продолжить работу в нём. Без активации вы вернётесь к системному Python.

3. Установка зависимостей: Git и прочее. В окружении Python готово, но нам ещё нужны некоторые системные инструменты. Прежде всего, убедимся, что установлен git – система контроля версий, с помощью которой мы скачаем код Stable Diffusion WebUI. Также пригодятся wget (для загрузки файлов) и пара библиотек, необходимых для графических интерфейсных компонентов Stable Diffusion (OpenGL/GLib – они нужны, чтобы, например, правильно работали некоторые вспомогательные скрипты отображения изображений). Установим всё одной командой:

sudo apt install -y git wget libgl1 libglib2.0-0

Если какие-то из этих пакетов уже были в системе, ничего страшного – менеджер пакетов их пропустит. Теперь у нас под рукой есть всё необходимое: Python 3.10, изолированный env, git, wget и нужные библиотеки. Можно переходить к установке самого приложения Stable Diffusion.

Установка Stable Diffusion WebUI (AUTOMATIC1111)

Мы будем использовать популярный веб-интерфейс Stable Diffusion WebUI от разработчика Automatic1111. Это удобная оболочка, запускающая Stable Diffusion и позволяющая управлять генерацией изображений через браузер. По сути, она делает работу с моделью практически «из коробки»: не нужно писать код, всё наглядно.

Находясь в активированном окружении (sd_env) и в домашней директории, выполните команду клонирования репозитория с кодом WebUI с GitHub:

cd stable-diffusion-webui

Начнёт скачиваться вся необходимая кодовая база (несколько сотен мегабайт). По завершении у вас появится папка stable-diffusion-webui. Перейдите в неё:

cd stable-diffusion-webui

Внутри находятся скрипты запуска и папки для моделей, настроек и результатов. Пока что там нет самой модели весов Stable Diffusion (о которой ниже), но уже есть всё для её запуска. Перед тем как мы загрузим модель, пару слов о настройках: в файле webui-user.sh можно при желании задать параметры запуска (например, какой порт использовать, нужно ли автоматически скачивать модели и т.д.). Однако трогать его не обязательно – мы передадим нужные параметры прямо при запуске команды.

Итак, программная часть установлена. Теперь осталось дать нашему «движку» сами нейросетевые веса модели – без них Stable Diffusion не сможет генерировать картинки (образно говоря, мы поставили «движок», но не залили в него топливо).

Готовы перейти на современную серверную инфраструктуру?

В King Servers мы предлагаем серверы как на AMD EPYC, так и на Intel Xeon, с гибкими конфигурациями под любые задачи — от виртуализации и веб-хостинга до S3-хранилищ и кластеров хранения данных.

- S3-совместимое хранилище для резервных копий

- Панель управления, API, масштабируемость

- Поддержку 24/7 и помощь в выборе конфигурации

Результат регистрации

...

Создайте аккаунт

Быстрая регистрация для доступа к инфраструктуре

Загрузка модели Stable Diffusion (weights)

Модель Stable Diffusion представляет собой файл-«мозг» нейросети, содержащий миллионы обученных параметров. Этот файл весит несколько гигабайт и по лицензии не включён прямо в репозиторий. Получить его можно из открытых источников – самый распространённый вариант: Hugging Face (крупный хаб моделей машинного обучения). Также существуют альтернативы вроде CivitAI (сообщество, делящееся готовыми моделями). Мы рассмотрим путь через Hugging Face на примере официальной модели Stable Diffusion v1-5.

wget вернёт HTML-страницу вместо файла.

Теперь загрузим модель прямо в нужную папку. Команда:

wget -O models/Stable-diffusion/v1-5-pruned.ckpt \\

https://huggingface.co/runwayml/stable-diffusion-v1-5/resolve/main/v1-5-pruned.ckpt

Что здесь происходит: флаг -O указывает имя выходного файла и путь. Мы сохраняем модель как v1-5-pruned.ckpt внутрь каталога models/Stable-diffusion в нашей папке WebUI. Репозиторий stable-diffusion-webui уже содержит нужную структуру папок – осталось только поместить файл. Размер загрузки около 4 ГБ, будьте готовы немного подождать (в это время можно налить кофе ☕). По завершении убедитесь, что файл на месте:

ls -sh models/Stable-diffusion/

Вы должны увидеть файл v1-5-pruned.ckpt размером ~4 000 000 KB (около 4 GB). Отлично, теперь у нас есть и «движок», и «топливо» – можно запускать нейросеть!

(Если скачивание с Hugging Face не получилось из-за прав, альтернативный способ – загрузить модель вручную через браузер с той же страницы и перенести файл на сервер, либо воспользоваться ресурсом CivitAI, где часто выложены модели без ограничения по токену. Однако официальный источник предпочтительнее для базовой модели.)

Запуск веб-интерфейса и первая генерация

Момент истины – сейчас мы запустим Stable Diffusion и попробуем сгенерировать первое изображение. Убедитесь, что находитесь в папке ~/stable-diffusion-webui и активировано окружение (sd_env) (если вы выходили из него). Далее выполняем команду запуска:

./webui.sh --xformers --listen

Разберём флаги: --listen говорит веб-интерфейсу принимать подключения не только с локального адреса, но и с внешнего (т.е. мы сможем зайти на него через браузер с своего компьютера по IP сервера). Без --listen интерфейс по умолчанию доступен только на 127.0.0.1 (локально для сервера), что нас не устраивает, ведь мы работаем удалённо. Второй флаг --xformers включает оптимизацию памяти и скорости с помощью библиотеки xFormers – это ускоряет генерацию и снижает потребление VRAM на совместимых GPU. Первый запуск скрипта может занять несколько минут: WebUI автоматически скачает все необходимые Python-библиотеки (Torch, torchvision, GFPGAN, и т.д.). Терминал будет выводить кучу строчек про установку пакетов – просто дождитесь завершения.

Когда всё готово, вы увидите примерно такой вывод в конце запуска:

Если вы указали --listen, адрес может быть 0.0.0.0:7860, что означает – сервис слушает на всех интерфейсах. Порт 7860 – стандартный для Stable Diffusion WebUI. Теперь настало время открыть браузер на вашем компьютере и подключиться к интерфейсу: введите в адресную строку http://<IP-адрес_вашего_сервера>:7860. Например: http://123.45.67.89:7860. Вы должны увидеть веб-страницу с интерфейсом Stable Diffusion (если всё запущено правильно и порт не заблокирован брандмауэром). Выглядит оно так:

Интерфейс Stable Diffusion WebUI (AUTOMATIC1111) после запуска на сервере: слева поля для текстового запроса (Prompt) и отрицательного запроса (Negative Prompt), справа – параметры генерации (число шагов, уровень CFG, размер изображения и т.д.), ниже – кнопка Generate и область для результатов.

Если страница не открывается, проверьте настройки доступа: возможно, на сервере включён фаервол, блокирующий внешний доступ к порту 7860. В таком случае можно либо настроить правило брандмауэра для разрешения этого порта, либо воспользоваться альтернативой – запустить WebUI с флагом --share. Флаг --share подключит ваш интерфейс к облачному сервису Gradio и выдаст публичный временный URL (в консоли вы увидите строку Running on public URL: ...gradio.live). Перейдя по нему, вы также получите доступ к интерфейсу без прямого подключения к IP (учтите, что такой способ менее защищён и подходит для разовых сессий). В большинстве случаев проще открыть нужный порт и использовать прямое подключение.

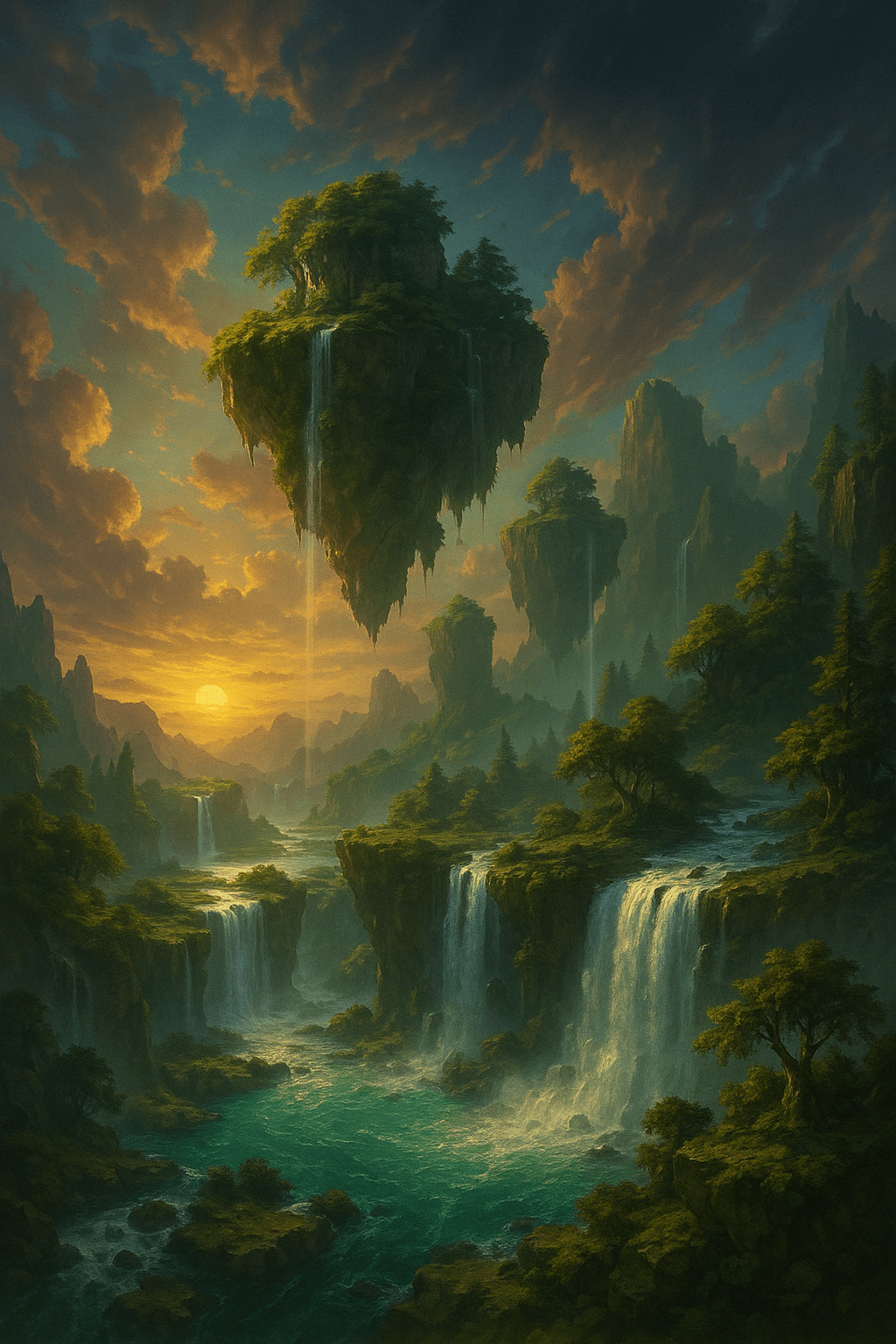

Теперь всё готово для тестирования! Давайте попробуем сгенерировать что-нибудь. В поле Prompt введите описание желаемого изображения. Например: a fantasy landscape with floating islands and waterfalls, epic lighting (фэнтезийный пейзаж с парящими островами и водопадами, эпичный свет). Можно писать и по-русски, но английские запросы обычно дают более предсказуемые результаты, так исторически сложилось с обучением модели. Установите параметры генерации: шаги (Steps) пусть будут 20–30, ширину/высоту изображения 512×512 (это базовое разрешение для модели 1.5), и смело жмите Generate («Сгенерировать»).

WebUI отправит ваш запрос модели, и вы увидите строку прогресса. Спустя ~10–30 секунд (в зависимости от сложности сцены и мощности GPU) в правой колонке появится сгенерированное изображение пейзажа. Поздравляем – вы только что собственными руками развернули и запустили Stable Diffusion! Ваш сервер превратился в настоящую AI-художественную студию. 🎨👩💻

Несколько советов по использованию интерфейса для дальнейших экспериментов:

- Вы можете уточнять запрос, добавляя детали или стили. Например:

oil painting of a mystic forest, by Ivan Shishkin– модель попробует сгенерировать лес в стиле живописи Шишкина. Чем точнее и образнее описание, тем интереснее результат. - Поле Negative Prompt позволяет задать, чего не должно быть на картинке. Это полезно, чтобы отсеять нежелательные элементы. Например, часто указывают

blurry, low quality, text, watermark– чтобы избежать размытости, надписей, «водяных знаков» и т.д. - В настройках (справа) можно менять CFG Scale (она же «коэффициент соответствия запросу») – при высоком значении (например, 12–15) модель будет более буквально следовать описанию, при низком (5–7) – будет креативнее и вольнее с трактовкой.

- Пробуйте разные модели! Stable Diffusion имеет множество вариантов и дообученных моделей от сообщества – их можно подключать так же, как вы скачали основную. К примеру, есть версии для аниме-стиля, фотореализма, рисунков карандашом и прочего. Достаточно поместить новые файлы

.ckptили.safetensorsв папкуmodels/Stable-diffusionи выбрать их в выпадающем списке вверху интерфейса. - Не бойтесь задавать вопросы сообществу – вокруг Stable Diffusion есть множество форумов и чатов, где новички получают поддержку. Да и команда King Servers всегда готова помочь с вопросами по серверу и окружению, если вдруг что-то не работает.

Итоги и новые горизонты

Мы проделали большой путь: взяли чистый сервер Ubuntu 20.04, настроили на нём драйверы NVIDIA и среду Python, установили Stable Diffusion WebUI, загрузили модель и успешно сгенерировали первые изображения. Теперь у вас в руках мощный инструмент: ваша собственная AI-лаборатория для создания визуального контента. 🎉

Подумайте только, ещё пару лет назад для таких экспериментов требовались дорогущие рабочие станции или долгие часы ожидания в облачных сервисах. А теперь – у вас есть гибкость запуска нейросети по требованию. Захотели вдохновения для дизайна или иллюстрацию к рассказу – пожалуйста, несколько минут и картинка готова. И всё это – без необходимости покупать и содержать громоздкий железный сервер у себя под боком.

GPU-сервер от King Servers сделал всё это возможным: вы арендуете мощность ровно на то время, которое нужно, и под свои задачи. Появилась идея нового проекта – взяли GPU на пару недель для прототипа. Проект вырос – масштабировались на более серьёзную карточку или несколько GPU. Не нужны ресурсы – отключили в один клик. Такой свободы не даст собственный ПК, а экономия времени и средств налицо.

Теперь, когда Stable Diffusion у вас настроен, не останавливайтесь на достигнутом! Попробуйте другие режимы WebUI: Img2Img (генерация вариаций от загруженной картинки), Inpainting (точечная дорисовка деталей на изображении по маске), Extras (улучшение разрешения с помощью апскейлеров). Творческий простор невероятно широк. Возможно, вы даже захотите обучить свою собственную модель или встроить Stable Diffusion API в приложение – и это тоже реально на вашем сервере.

В заключение, хочется сказать: вы молодец 😊. Вы своими руками развернули сложную систему, разобравшись с технологиями по ходу дела. Теперь перед вами открыт мир генеративного искусства и AI-инструментов. Экспериментируйте, создавайте, вдохновляйтесь. А если потребуется ещё больше мощности или новые эксперименты – вы знаете, что делать. GPU-VPS от King Servers всегда к вашим услугам, предлагая новейшее железо и надёжную поддержку, чтобы ваши самые смелые идеи стали реальностью.

Самое время действовать: запускайте новые запросы в Stable Diffusion, играйте с настройками, пробуйте разные стили. Мир творчества ждёт – вперед, к новым потрясающим изображениям, созданным силой вашего воображения и мощью GPU! 🚀👨🎨👩🎨