Оглавление

Введение

Почти все слышали истории успеха о микросервисах – как они позволяют создавать более гибкие и масштабируемые приложения. Разделение монолита на десятки независимых сервисов действительно ускоряет развитие и масштабируемая архитектура становится реальностью. Но вместе с преимуществами приходят и новые сложности. В определённый момент команды сталкиваются с проблемами: как обеспечить надёжная связность сервисов, единые правила доступа и видимость того, что происходит между ними? Как упростить управление микросервисами, когда их уже не пять, а пятьдесят? Тут на помощь приходит service mesh.

Эксперты недаром называют сервис-меш «швейцарским ножом» для современных распределённых систем. Он предназначен именно для того, чтобы решить самые хитрые задачи сетевого взаимодействия внутри сложного приложения. Энергично ворвавшись в мир DevOps, эта технология стала своего рода невидимым дирижёром, который помогает вашим сервисам общаться друг с другом безопасно, эффективно и предсказуемо. Давайте разберёмся, как работает сервис-меш, какие преимущества он даёт и – что не менее важно – когда его использование действительно оправдано.

Что такое сервис-меш и как он работает?

Проще говоря, service mesh – это дополнительный инфраструктурный слой, своего рода умная сеть, которая берёт на себя управление коммуникацией между сервисами. Представьте себе Kubernetes-кластер или другой окружитель контейнеров, где одновременно работают десятки микросервисов. Каждый из них должен обмениваться данными с другими, и всё это взаимодействие должно быть надёжным, безопасным и управляемым. Вместо того чтобы встраивать логику сетевого взаимодействия (авторизация, шифрование, ретраи, мониторинг и т.д.) в код каждого сервиса, сервис-меш выносит эти общие задачи «наружу» – в отдельный уровень, которым можно централизованно управлять.

Основной технический приём, с помощью которого работает большинство сервис-мешей, – это модель sidecar (буквально «коляска мотоцикла»). К каждому экземпляру микросервиса «подключается» небольшой вспомогательный прокси (sidecar-контейнер), который перехватывает весь входящий и исходящий сетевой трафик этого сервиса. Можно сказать, у каждого микросервиса появляется свой личный ассистент, отвечающий за сетевую коммуникацию. Mesh-сеть для приложений формируется как раз посредством взаимодействия этих многочисленных прокси между собой. В результате все важные функции – маршрутизация запросов, проверка доступа, шифрование данных, сбор метрик – выполняются на уровне инфраструктуры, а не в бизнес-коде приложений. Сами же сервисы могут сосредоточиться на своей логике, не отвлекаясь на сетевые рутинные задачи.

Стоит отметить, что сервис-меш не привязан строго к Kubernetes, но чаще всего реализуется поверх него. Платформа оркестрации контейнеров решает задачу деплоя и масштабирования, а сервис-меш дополняет её, отвечая за защиту межсервисного взаимодействия и управление сетью внутри кластера. Такой тандем можно образно представить как организм: Kubernetes – скелет и мышцы, двигающие контейнеры, а mesh – нервная система, обеспечивающая координацию и рефлексы. Кстати, сегодня появляются и новые подходы к реализации mesh-инфраструктуры (например, Istio Ambient Mesh или сервис-меш на основе eBPF в Cilium), где прокси запускаются не как сайдкары, а в виде отдельных демонов в узлах кластера. Однако принцип остаётся тем же: добавить умный слой, который управляет сетевым взаимодействием микросервисов.

Зачем нужен сервис-меш: ключевые возможности и преимущества

Сервис-меш приносит целый букет полезных возможностей, упрощающих жизнь разработчикам и DevOps-инженерам. Ниже перечислим основные из них – те самые «фишки», ради которых компании внедряют mesh. Каждое из преимуществ сопровождается мини-примером или аналогией, чтобы было проще представить практическую ценность.

- Единая авторизация и шифрование трафика. Service mesh позволяет централизованно задавать политику безопасности для всех внутренних вызовов. Все сервисы могут автоматически взаимно проверять подлинность (mTLS) и обмениваться данными по зашифрованным каналам. Например, если раньше разработчикам приходилось настраивать TLS между каждым отдельным сервисом вручную, то с mesh это решается «одним махом» для всего кластера. В результате защита межсервисного взаимодействия выходит на новый уровень: никакой сервис не отправит данные другому без проверки удостоверения, а весь трафик шифруется по умолчанию. Можно сказать, что сервис-меш раздаёт всем вашим сервисам служебные пропуски и шифрованные телефоны – они узнают «своих» и шепчутся на своём секретном языке.

- Автоматическая балансировка и ретраи запросов. Ещё одно ключевое преимущество – встроенное управление трафиком. Сервис-меш умеет автоматически распределять нагрузку между множеством экземпляров сервисов и перенаправлять запросы при сбоях. Если один инстанс упал или еле «дышит» под нагрузкой, mesh-сеть перенаправит трафик на здоровые экземпляры, не ожидая вмешательства админа. Кроме того, умная сеть выполнит ретраи – повторные попытки запросов – когда это имеет смысл: например, если произошёл временный сбой или таймаут. Представьте, пользователь нажимает кнопку, и запрос пролетает через несколько сервисов. Один из них «замешкался» и не ответил вовремя – без mesh пользователю бы пришла ошибка. Но с mesh-инфраструктурой Istio или Linkerd можно задать политику: если нет ответа 2 секунды, повторить запрос до 3 раз. Часто этого достаточно, чтобы переждать кратковременный сбой, и пользователь даже не узнает, что какой-то микросервис оступился по пути. Таким образом, балансировка трафика и механизмы наподобие retry делают систему гораздо устойчивее к сбоям без дополнительной логики в самих сервисах.

- Наблюдаемость и отслеживание зависимостей. В микросервисном «живом организме» крайне важно видеть, что происходит между компонентами. Service mesh значительно повышает наблюдаемость микросервисов: собираются метрики по каждому вызову, строятся детальные логи и трассировки (distributed tracing). Это означает, что можно проследить путь конкретного запроса через всю систему – какие сервисы он прошёл, сколько времени занял на каждом этапе, где случились задержки. Например, вместо того чтобы гадать, почему пользователю долго грузится страница, вы увидите в трейс-логах, что запрос тормозит на обращении к сервису БД, и сможете локализовать узкое место за минуты. Mesh фактически даёт «рентгеновское зрение» на ваш стек: вы всегда знаете, как сервисы взаимосвязаны и к чему приводит сбой одного из них. Более того, собранные mesh-сетью метрики можно вывести в привычные панели Grafana, а трассировку – проанализировать через Jaeger или Zipkin. Эта прозрачность помогает не только чинить проблемы, но и оптимизировать архитектуру, ведь отслеживание зависимостей между сервисами – ключ к выявлению неэффективных маршрутов и тяжелых запросов.

- Единообразие и упрощение управления. Наконец, сервис-меш объединяет все перечисленные функции в единый «ящик с инструментами», которым удобно управлять централизованно. DevOps-специалисты получают консоль или YAML-манифесты, где можно задать правила для всего mesh сразу – будь то политика безопасности или лимиты трафика. Это избавляет команды от необходимости реализовывать дублирующие решения в каждом микросервисе. В итоге снижается сложность приложений: код сервисов становится чище, а риск ошибок из-за человеческого фактора уменьшается. Представьте, что раньше разработчики каждого сервиса как могли реализовывали у себя авторизацию, логи или балансировку – кто в лес, кто по дрова. Теперь вместо десятка разрозненных реализаций у вас одна согласованная система, которую легче поддерживать и обновлять. Таким образом, mesh-подход упрощает управление микросервисами как на уровне сетевых настроек, так и в плане командной работы – правила понятны всем, и они едины для всего приложения.

Важно отметить, что введение сервис-меша само по себе не улучшит код и не исправит архитектурные просчёты. Однако если у вас уже выстроена масштабируемая архитектура на микросервисах, mesh-сеть поможет раскрыть её потенциал на полную. Вы получите более наблюдаемость и безопасность микросервисов, устойчивость к сбоям и гибкость управления трафиком – факторы, которые особенно ценят в продакшене и при высоких нагрузках.

Готовы перейти на современную серверную инфраструктуру?

В King Servers мы предлагаем серверы как на AMD EPYC, так и на Intel Xeon, с гибкими конфигурациями под любые задачи — от виртуализации и веб-хостинга до S3-хранилищ и кластеров хранения данных.

- S3-совместимое хранилище для резервных копий

- Панель управления, API, масштабируемость

- Поддержку 24/7 и помощь в выборе конфигурации

Результат регистрации

...

Создайте аккаунт

Быстрая регистрация для доступа к инфраструктуре

Когда сервис-меш особенно полезен?

Как понять, пришло ли время задуматься о внедрении сервис-меша? Есть несколько характерных ситуаций и масштабов, при которых выгоды от mesh многократно перевешивают издержки.

Во-первых, масштаб и сложность: если у вас десятки (а тем более сотни) микросервисов, между которыми летают тысячи запросов в минуту, ручное управление их связями перестаёт работать. Чем больше сервисов, тем труднее проследить зависимости и обеспечить стабильное поведение всего приложения. Сервис-меш особенно полезен в таких крупных распределённых системах – он обеспечивает на порядки более надёжную связность сервисов и контроль над хаосом, который иначе неминуемо возникает. По мере роста архитектуры рано или поздно наступает «толчковый момент», когда встроенных средств коммуникации и простых библиотек уже недостаточно. Если проигнорировать этот момент, можно столкнуться с чередой загадочных сбоев и регрессий, когда сервисы начинают «спотыкаться» друг об друга. Наличие же mesh-платформы заранее, до наступления кризиса, помогает пройти пик сложности без потерь.

Во-вторых, требования к безопасности и соответствию стандартам. Некоторые организации (например, в финансовом или государственном секторе) требуют повсеместного шифрования данных и строгой аутентификации между всеми компонентами. Реализовать такие политики силами отдельных сервисов крайне трудоёмко и чревато ошибками. Здесь сервис-меш фактически незаменим: он гарантирует, что каждый вызов внутри системы проходит проверку прав доступа и шифруется согласно единому стандарту. Если ваши микросервисы обрабатывают чувствительные данные или должны соответствовать требованиям стандарта (вроде PCI DSS, HIPAA и т.п.), mesh поможет удовлетворить эти требования без драматичного усложнения логики приложений.

В-третьих, обзор и контроль над системой. Бывают случаи, когда ваша основная боль – это неопределённость: вы знаете, что что-то периодически падает или тормозит, но не можете отследить цепочку событий. Или вы подозреваете, что неэффективная маршрутизация трафика тратит ресурсы впустую. Прежде чем слепо оптимизировать каждый сервис в отдельности, стоит попробовать внедрить mesh и получить полную картину. Повышенная наблюдаемость, которую даёт mesh-сеть, окажется бесценной, если у вас сложная система с множеством зависимостей. Особенно это актуально для команд SRE и DevOps: с mesh им проще держать руку на пульсе распределённого приложения, отслеживать SLA и быстро находить узкие места.

Наконец, мультиоблачные и гибридные среды. Если ваши микросервисы развернуты в нескольких разных кластерах, регионах или даже на разных платформах (например, часть в Kubernetes, часть на виртуальных машинах), задача их связности усложняется кратно. Некоторые сервис-меш решения (например, Consul от HashiCorp) позволяют объединять сервисы из разных сред в единую mesh-фабрику, управляя трафиком сквозь облака и дата-центры. Таким образом, при сложной инфраструктуре mesh способен стать тем связующим звеном, которое скроет от разработчиков различия между средами и обеспечит единообразные коммуникации повсюду.

Накладные расходы и сложности внедрения

Перед тем как с головой бросаться в прекрасный мир сервис-меша, честно оцените обратную сторону медали. За удобство приходится платить – и не только в прямом финансовом смысле, но и ростом сложности системы. Вот какие накладные расходы и сложности могут вас ожидать:

- Потребление ресурсов и оверхед. Добавляя ко всем вашим сервисам побочный прокси-контейнер, вы увеличиваете нагрузку на процессоры и память кластеров. Каждый сетевой вызов теперь проходит через дополнительный этап (sidecar), что может слегка добавить задержку (латентность) и потребление CPU. В небольших масштабах это почти незаметно, но на уровне сотен сервисов суммарный overhead может быть существенным. Реальные кейсы показывают, что неэффективная настройка mesh способна «съесть» ресурсы: например, были случаи, когда сайдкар Istio увеличивал потребление CPU на контейнер в 5 раз. Конечно, с развитием технологий (и появлением тех же sidecar-less архитектур) эффективность улучшается, но закладывать дополнительные ресурсы под mesh-инфраструктуру всё же придётся.

- Сложность настройки и обучения. Сервис-меш – мощный, но довольно сложный инструмент, особенно такой богатый функционалом, как Istio. Команде потребуется время, чтобы разобраться с новой концепцией: как работают control plane и data plane, как писать манифесты или конфиги для политики маршрутизации, как мониторить сам mesh. Без достаточной подготовки есть риск настроить систему неправильно и получить либо недостаточный эффект, либо, хуже того, новые проблемы. Придётся инвестировать в обучение инженеров и, возможно, завести практику Platform Engineering – когда выделенные специалисты помогают остальным командам пользоваться платформенными штуками вроде mesh. Да и разработчикам полезно понимать, что делает mesh «под капотом», иначе при отладке они могут растеряться. В общем, будьте готовы преодолеть кривую обучения.

- Операционные накладные расходы. Mesh-система сама по себе требует поддержки: её нужно разворачивать, обновлять, мониторить. Появляются новые компоненты (например, контроллеры Istio, прометей для метрик, графана для красивых графиков, трейсинг-сервисы), которые тоже надо где-то хостить и поддерживать в работоспособном состоянии. Это дополнительная нагрузка на вашу команду DevOps/SRE. Фактически вы вводите ещё один уровень инфраструктуры, которым тоже надо управлять. Если компания небольшая и до этого еле-еле справлялась с одним Kubernetes-кластером, то добавление mesh может быть преждевременным утяжелением.

- Совместимость приложений. В большинстве случаев сервис-меш прозрачен для приложений, но бывают нюансы. Некоторые специфические ворклоды (например, короткоживущие batch-задания или системы типа Serverless) могут не ладить с моделью постоянного sidecar-агента. К примеру, задача, которая выполняется за доли секунды, может неоправданно задерживаться на запуске proxy-контейнера или ждать, пока тот подключится к mesh-сети. В редких случаях встречаются конфликты: если ваше приложение очень нестандартно работает с сетью, возможно, придётся тонко настраивать mesh или вовсе отказаться от него для данного компонента. Поэтому перед широким внедрением стоит протестировать mesh на самых критичных сервисах и убедиться, что он не мешает их работе.

Итак, сервис-меш добавляет собственный слой сложности, и его внедрение – это небольшой проект, требующий ресурсов. Но при грамотном подходе эти издержки окупаются – за счёт экономии времени на разработку, более быстрого обнаружения сбоев и повышения стабильности системы.

Внедрять сразу или постепенно?

Один из самых частых вопросов – когда именно стоит внедрять сервис-меш: с самого начала проекта или дождаться определённого масштаба? Универсального рецепта нет, но опыт сообществ показывает несколько разумных стратегий.

Если вы только начинаете путь с микросервисами, не торопитесь подключать mesh с первого дня, особенно если система небольшая. На ранних этапах важнее отладить сами сервисы и наладить базовую оркестрацию (тот же Kubernetes), чем усложнять картину дополнительным слоем. Однако полезно «про запас» закладывать совместимость: убедитесь, что ваши сервисы не содержат в себе логики, дублирующей mesh (скажем, пусть механизмы ретраев можно отключить), и что инфраструктура позволяет добавить прокси в будущем.

По мере роста, наблюдайте за комплексностью проблем. Когда видите, что микросервисная архитектура достигла высокой сложности, и вас начинают тормозить задачи, которые mesh решает из коробки – например, слишком много усилий уходит на поддержку самописного логирования, или безопасность внутренних API вызывает головную боль, – это сигнал, что пора пробовать сервис-меш. Как советуют архитекторы, важно уловить момент, когда библиотеки и костыли больше не справляются, и подготовить mesh-запаску заранее, до того как всё начнёт рушиться под нагрузкой.

Внедряйте сервис-меш постепенно, а не «всё и сразу». Начните с пилотного проекта: выберите часть системы или не самый критичный кластер, разверните там, к примеру, Istio или Linkerd и посмотрите в действии. Это позволит команде набить руку, выявить подводные камни настройки именно под ваши сервисы. Далее можно поэтапно подключать новые сервисы к mesh-сети, обучая параллельно разработчиков пользоваться её возможностями. Помните, что mesh – это инструмент, и его ценность раскрывается только если люди правильно им пользуются. Не стесняйтесь привлекать экспертов или обращаться за поддержкой сообщества (у популярных mesh есть чаты, форумы) на этапе внедрения.

И конечно, оценивайте выгоду на каждом шаге. Сервис-меш – не самоцель, а средство. Если на каком-то этапе вы поймёте, что обходных решений вам достаточно, возможно, полновесный mesh и не нужен. Но чаще бывает наоборот: попробовав на небольшом участке и увидев улучшения в мониторинге, безопасности и скорости реакции на сбои, команды решают распространять mesh на все сервисы.

Популярные инструменты и примеры

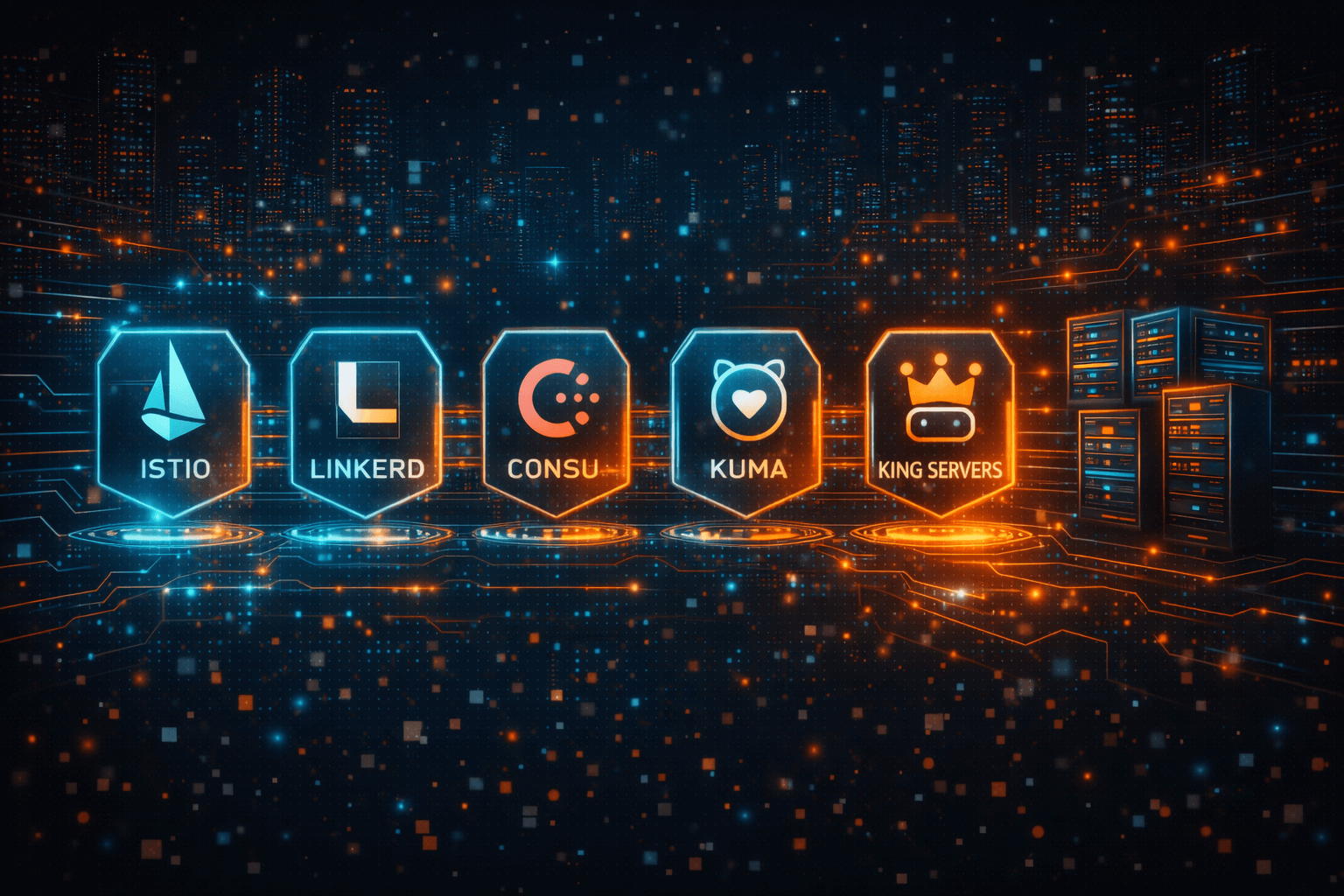

Экосистема сервис-мешей уже достаточно богата. На рынке есть как открытые решения, так и облачные сервисы. Кратко упомянем несколько наиболее популярных вариантов:

- Istio – пожалуй, самый известный open-source сервис-меш, изначально разработанный при участии Google, IBM и Lyft. Использует в качестве sidecar-прокси мощный Envoy. Отличается богатым функционалом и гибкостью настроек, что одновременно его плюс и минус: Istio требует определённых навыков и довольно «тяжеловесен» по умолчанию. Зато он поддерживает практически все перечисленные возможности (mTLS, продвинутый traffic shifting, комплексная наблюдаемость, отказоустойчивость) из коробки. Многие крупные Kubernetes-кластеры в продакшене работают на связке Kubernetes с mesh-инфраструктурой (например, Istio), чтобы удовлетворить высокие требования по безопасности и управляемости трафика.

- Linkerd – легковесная и простая в установке альтернатива Istio. Проект, входящий в CNCF, ориентирован на то, чтобы дать основные возможности mesh с минимальными накладными расходами. Linkerd обычно выбирают команды, которым важна скорость и простота: он потребляет меньше ресурсов, быстрее осваивается, но и функционально чуть беднее (например, меньше гибкости в сложных сценариях маршрутизации трафика). Хороший выбор для небольших и средних проектов, где нужен базовый mesh-эффект без избыточной сложности.

- Consul Connect (часть HashiCorp Consul) – решение, которое часто применяют, когда нужно связать сервисы в разных средах (Kubernetes, виртуальные машины, bare metal). Consul одновременно даёт и сервис-дискавери, и ключевой функционал mesh, используя всё тот же Envoy под капотом. Его выбирают, если инфраструктура гибридная или мультиоблачная, поскольку Consul меньше завязан на Kubernetes и хорошо интегрируется с продуктами HashiCorp (Vault, Nomad и др.).

- Kuma – ещё один проект (от компании Kong), делающий ставку на универсальность. Kuma может работать и в Kubernetes, и без него, настраивается через единую бинарную утилиту, поддерживает multi-tenancy. Он менее распространён, чем Istio или Linkerd, но набирает популярность в специфических сценариях.

Отдельно отметим, что крупные облачные провайдеры тоже предлагают свои сервис-меш сервисы – например, AWS App Mesh или Azure Service Mesh, которые скрывают часть сложности в виде управляемого сервиса. Тем не менее, принципы у всех решений схожи.

Выбор инструмента зависит от ваших потребностей: Istio – для максимальных возможностей, Linkerd – для быстроты и простоты, Consul – для гибридных сред, и т.д. Иногда стартуют с более простого Linkerd, а затем, при росте требований, переходят на Istio. В любом случае, здорово, что экосистема развита и вы не привязаны к одному вендору.

Не забудем про инфраструктуру: какой бы mesh вы ни выбрали, ему нужна надёжная среда для работы. Например, если у вас уже есть распределённые микросервисные приложения или Kubernetes-кластеры, важно развернуть mesh на производительной платформе. Здесь в роли фундамента отлично подойдут проверенные хостинг-провайдеры. Так, King Servers может служить подходящей платформой для развёртывания сервис-меша – его мощности и сеть позволяют уверенно оперировать «сетью сервисов», особенно когда речь о множестве контейнеров и высоком трафике. Клиенты King Servers, имеющие сложные микросервисные системы, смогут интегрировать mesh-решения (например, тот же Istio) в свою инфраструктуру без лишних волнений за железо и пропускную способность. Когда инструменты уровня mesh работают на базе стабильной и быстрой хостинговой платформы, вы получаете максимум выгоды от обеих составляющих.

Заключение

Service mesh для микросервисов – это не сиюминутная мода, а закономерный этап развития архитектуры, когда простых решений уже недостаточно. Как любая технология, сервис-меш – это инструмент: в умелых руках он творит чудеса (делает систему более прозрачной, безопасной и устойчивой), а в неготовых может добавить лишней сложности. Мы разобрали, как работает эта «умная сетка» – через сеть прокси, координирующих трафик между сервисами, – и увидели, какие преимущества она приносит. Единая авторизация, сквозное шифрование, автоматическая балансировка, ретраи, наблюдаемость, трассировка – всё это повышает уровень вашего приложения до корпоративных стандартов надёжности. Конечно, не бывает решений без издержек: mesh потребует ресурсов и внимания. Но если ваша система выросла и стремится к лучшим практикам, сервис-меш может стать именно тем недостающим элементом пазла.

В конечном счёте, решать вам. Возможно, прямо сейчас вы держите ситуацию под контролем и обходитесь без mesh – что ж, здорово! Но если читая эту статью вы узнали свои боли: сложности с мониторингом, проблемы с межсервисной безопасностью или мучительные настройки балансировки – стоит присмотреться к сервис-мешу ближе. Начните с малого: выберите инструмент, попробуйте в тестовом окружении, ощутите, как меняется управление микросервисами. Вполне вероятно, вам уже не захочется возвращаться к ручному труду там, где работа может идти автоматически и прозрачно. Сервис-меш не решит за вас всех проблем разработки, но станет надёжным союзником в пути к масштабируемой, управляемой и защищённой архитектуре. А значит – сделает ещё один шаг к тому, чтобы вы могли сосредоточиться на главном: создании ценности для ваших пользователей, не отвлекаясь на рутину инфраструктуры. Успехов вам в этом пути – и пусть ваша сеть сервисов всегда работает как единое слаженное целое!