Оглавление

Введение

Представьте, что вы выпустили в продакшен умный сервис на основе ИИ. Первое время он радует идеальной работой — молниеносно отвечает на запросы, точно предсказывает результаты, пользователи довольны. Но со временем мир вокруг меняется: нагрузка растёт, данные поступают новые, а модель может постепенно терять форму. Как узнать заранее, что стабильность работы моделей под угрозой, вместо того чтобы в панике тушить пожары уже после сбоя? Здесь на помощь приходит мониторинг AI-сервисов в реальном времени. Это как приборная панель самолёта для вашей ML-системы: показывает текущую производительность ML-систем и предупреждает о проблемах ещё до того, как они станут катастрофой.

Хорошо настроенный мониторинг — ваш круглосуточный «дежурный», который следит за здоровьем модели и инфраструктуры. Он вовремя заметит, если выросло время отклика или упала точность предсказаний, и даст вам возможность принять меры до того, как пользователи заметят сбой. В этой статье мы разберём, какие метрики обязательно нужно отслеживать, как настроить мониторинг AI-моделей с помощью Prometheus и Grafana, как внедрить систему оповещений (алертинг) и другие лучшие практики MLOps для поддержания AI-сервисов в боевой готовности. Материал изложен простым живым языком — от инженера для инженеров, с примерами и советами из реальной практики.

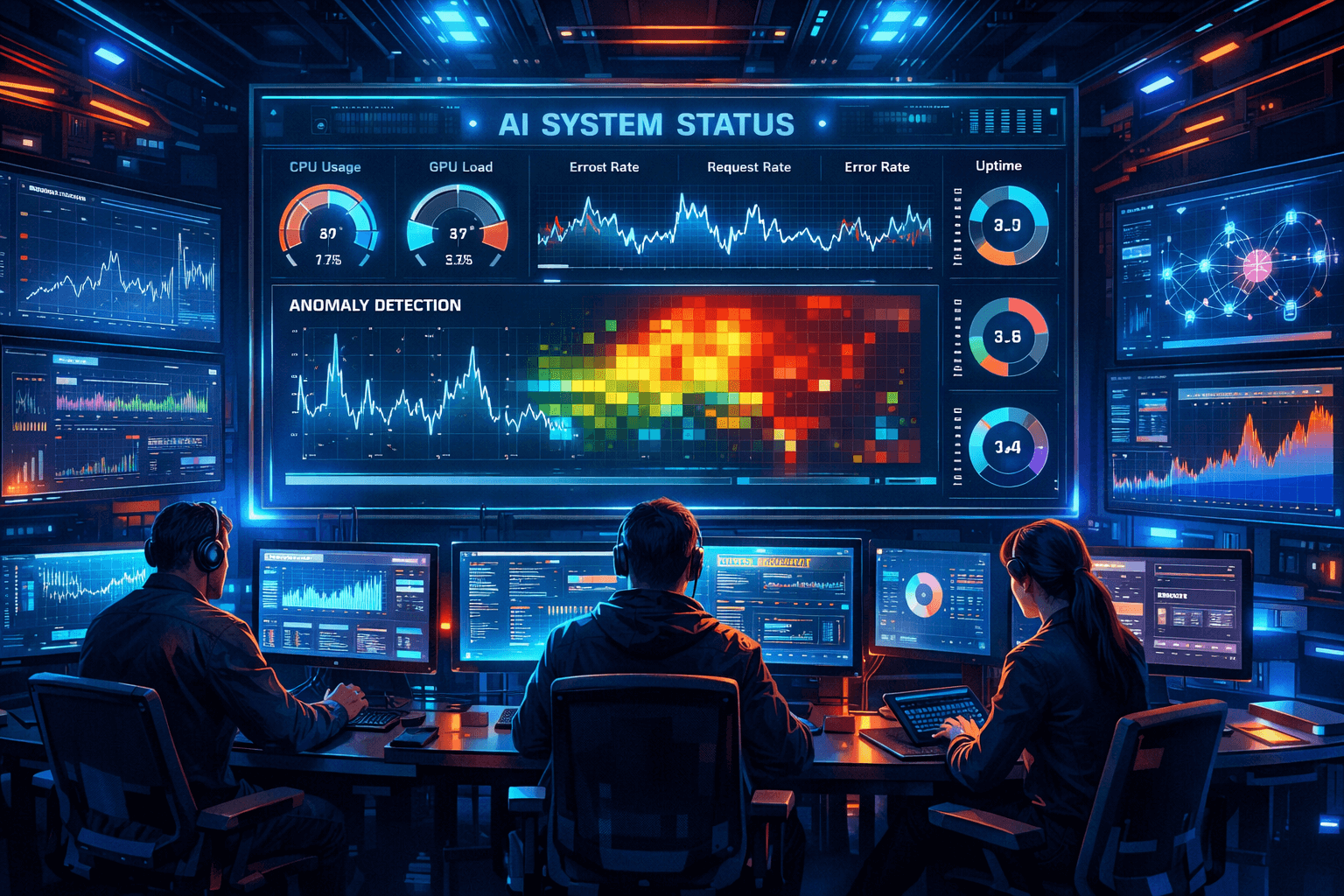

Ключевые метрики для стабильности AI-сервисов

Прежде чем настраивать инструменты, важно понять, что именно мы хотим измерять. Мониторинг ради мониторинга мало полезен — нужны конкретные показатели, которые отражают здоровье и стабильность работы моделей в продакшене. Вот четыре ключевые группы метрик, на которые стоит обратить внимание, и почему они важны.

Время отклика (Latency)

Скорость, с которой ваш AI-сервис отвечает пользователям, критически важна. Никто не любит ждать: если модель думает слишком долго, пользователь может закрыть приложение или обратиться к конкуренту. Время отклика измеряется обычно в миллисекундах — например, 99-й перцентиль latency покажет, за какое время отвечают 99% запросов. Представьте разговор с чат-ботом, который задумался на 5 секунд после каждого вопроса: даже самый умный ответ потеряет ценность, если ждать его слишком долго. Отслеживая задержки, вы сможете заметить, когда сервис начинает «тормозить», и разобраться в причинах — будь то возросший объём данных, недостаток ресурсов или неэффективный код модели.

Нагрузка и ресурсы

AI-модели прожорливы: они активно потребляют CPU, память, а особенно — GPU, если она используется для ускорения вычислений. Метрики нагрузки помогают убедиться, что ваша инфраструктура справляется. Сюда относятся загрузка процессора (CPU utilization), потребление оперативной памяти, использование GPU (в процентах или даже в ваттах мощности) и показатели сети (трафик, задержки). Важна и пропускная способность — сколько запросов в секунду обслуживает модель (throughput). Если сервис близок к пределам по ресурсам, он рискует начать сбоить: как автомобиль, который едет на красной зоне тахометра. Например, если вы видите, что модель постоянно выбивает 90–100% загрузки GPU, это тревожный знак — либо нужен более мощный GPU-сервер, либо масштабирование на несколько инстансов. Мониторинг этих метрик позволяет держать руку на пульсе: вы заранее узнаете, что память на исходе или CPU загружен под завязку, и успеете добавить мощности прежде, чем сервис упадёт.

Готовы перейти на современную серверную инфраструктуру?

В King Servers мы предлагаем серверы как на AMD EPYC, так и на Intel Xeon, с гибкими конфигурациями под любые задачи — от виртуализации и веб-хостинга до S3-хранилищ и кластеров хранения данных.

- S3-совместимое хранилище для резервных копий

- Панель управления, API, масштабируемость

- Поддержку 24/7 и помощь в выборе конфигурации

Результат регистрации

...

Создайте аккаунт

Быстрая регистрация для доступа к инфраструктуре

Точность предсказаний

Что пользы от молниеносного отклика, если ответы модели неверны? Точность предсказаний — ключевой показатель качества ML-модели. Однако измерять её в онлайне не так просто, как скорость или CPU. Нужны эталонные ответы (ground truth), чтобы сравнивать с предсказаниями. В некоторых сервисах это возможно: к примеру, модель пытается предсказать, купит ли пользователь товар, а реальный результат (купил или нет) станет известен через некоторое время. Собирая такие данные обратной связи, можно регулярно считать точность, precision/recall или другие метрики качества.

Если же мгновенной обратной связи нет (например, модель классифицирует картинки без последующей проверки человеком), на помощь приходят косвенные метрики: дрейф модели и данных. Дрейф — это изменение статистики входных данных или выходов модели со временем. Проще говоря, модель начинает "стареть": реальные данные постепенно уходят от тех, на которых она училась, и точность может падать. Отслеживая дрейф (через метрики вроде распределения ответов или статистические тесты на входные данные), вы сможете заметить, что модель требует переобучения ещё до катастрофического падения качества.

Надёжность и отказоустойчивость

Даже быстрая и точная модель бесполезна, если сервис недоступен или часто сбоит. Метрики надёжности показывают, насколько ваш AI-сервис устойчив к проблемам. Сюда относятся uptime (время бесперебойной работы сервиса), процент успешных ответов (сколько запросов завершается успешно vs. с ошибкой), а также частота отказов или перезапусков. Например, вы можете отслеживать метрику ошибок (HTTP 5xx ответы от сервиса) и время восстановления после сбоя (MTTR). Если модель развёрнута на нескольких узлах, важна и система оркестрации: может ли трафик автоматически перераспределиться, если один из узлов падает? Представьте сервис распознавания речи, который должен работать 24/7. Если в час пик вдруг отказала одна из двух нод, нагрузка ляжет на оставшуюся — без масштабирования и алертов она рискует тоже не выдержать. Мониторинг и здесь выручает: он фиксирует сбой, переключает трафик (если настроен автоскейлинг или резерв) и шлёт вам сигнал. В идеале, правильно спроектированная ML-система имеет встроенную отказоустойчивость (например, резервную модель или сервер), а мониторинг помогает убедиться, что эти механизмы сработали, и информирует команду о случившемся инциденте.

Настройка Prometheus и Grafana для мониторинга AI-сервисов

Итак, мы определились, что хотим отслеживать. Теперь — как это реализовать технически. Одним из самых популярных стеков для мониторинга в DevOps (и MLOps) является связка Prometheus и Grafana. Эти инструменты как раз и созданы для сбора метрик, построения красивых дашбордов и даже алертинга. Давайте рассмотрим пример настройки мониторинга AI-сервиса на практике.

Предположим, у вас есть веб-сервис, который обращается к ML-модели (например, REST API на Flask или FastAPI, выдающий предсказания). Первым делом нужно встроить сбор метрик в код этого сервиса. Это называется инструментирование (instrumentation). В случае Python можно использовать библиотеку prometheus_client, которая позволит засечь нужные показатели. Вы добавляете, например, счётчик (Counter) для количества обработанных запросов, гистограмму (Histogram) для времени обработки каждого предсказания, метрику для размера входных данных и т.п. Эти метрики автоматически будут доступны по специальному URL (например, /metrics). Аналогично, если модель работает через другую платформу (например, TensorFlow Serving или NVIDIA Triton), у них часто уже встроены подобные метрики, осталось их включить.

Параллельно имеет смысл собирать общесистемные метрики. Здесь выручит Node Exporter — маленькая утилита, которая собирает статистику ОС: загрузку CPU, память, диск, сеть и т.д. Вы устанавливаете Node Exporter на сервер с моделью, и он тоже начинает выдавать цифры (например, на порту 9100 по протоколу Prometheus).

Теперь очередь Prometheus. Это «сердце» системы мониторинга — сервис, который раз в несколько секунд опрашивает ваши источники метрик и складывает данные в базу (временной ряд). Настроим prometheus.yml: пропишем там наши цели (targets) — например, localhost:9100 (Node Exporter) и адрес вашего AI-сервиса (допустим, localhost:8000/metrics для метрик приложения). Как только Prometheus запущен и сконфигурирован, он начнёт собирать все указанные метрики автоматически. Можно выдохнуть: данные уже накапливаются!

Но сырые цифры в базе — это ещё не всё. Человеку удобнее видеть графики и диаграммы. Подключаем Grafana — популярнейший инструмент для визуализации. В Grafana добавляем источник данных Prometheus (по URL, где запущен Prometheus сервер). Далее создаём дашборд: например, панель с графиком времени отклика (берём нашу гистограмму latency и выводим её перцентили), панель с текущей загрузкой CPU и памяти, показатель точности (если мы его вычисляем) и т.д. Grafana очень гибкая: можно настроить цветовые зоны (например, подсвечивать красным, если latency вышел за предел 1 секунды), строить сложные комбинации метрик, добавлять текстовые пояснения. В итоге у вас получается «кокпит», где на одном экране видно все важнейшие параметры работы вашей ML-модели. Например, в реальном времени вы можете наблюдать, как на графике растёт нагрузка во время вечернего пика пользователей, и одновременно видеть, не просела ли точность предсказаний при этом.

Представьте утро понедельника: команда открывает Grafana-дэшборд и сразу видит, что на выходных модель отработала стабильно — нагрузка росла, но задержки держались в норме, точность не деградировала. Такое спокойствие дорогого стоит! А если что-то выглядит подозрительно (скажем, график дрейфа модели начал ползти вверх), можно сразу перейти к расследованию, пока проблема не стала острой.

Алертинг в MLOps: автоматические тревоги

Конечно, нельзя физически сидеть 24/7 и глазеть на графики, сколько бы ни был красив дашборд. Да и не нужно — для этого существует алертинг в MLOps. Алерты — это автоматические оповещения о том, что система превысила допустимые пределы. Они работают как пожарная сигнализация: молчат, пока всё хорошо, но стоит чему-то пойти не так — поднимают шум, чтобы разбудить дежурного инженера.

В Prometheus алертинг настраивается через правила Alerting Rules. Вы задаёте условия (например, «если среднее время отклика за 5 минут превышает 1 секунду» или «если доля ошибок 5xx больше 1% запросов за последний час»). Prometheus постоянно проверяет эти правила при сборе метрик. Если условие выполняется, он помечает соответствующий алерт как сработавший. Но чтобы доставить сообщение инженерам, нужен напарник — Alertmanager. Это отдельный компонент, который получает от Prometheus сигнал «тревога!» и уже отвечает за рассылку уведомлений. Alertmanager можно настроить отправлять алерты куда угодно: на email, в Slack, в Telegram, в SMS — что вашей душе (и корпоративным политикам) угодно.

Например, вы можете сделать так: если точность модели упала ниже оговоренного порога (скажем, accuracy классификатора меньше 85% в течение часа) — система шлёт уведомление в Telegram-чат команды MLOps с пометкой «⚠️ Возможна деградация модели, проверьте данные и метрики». Или проще: если загрузка GPU держится выше 95% более 10 минут — отправлять письмо на почту ответственного с темой «Срочно: модель упёрлась в GPU, рассмотрите масштабирование». Хорошей практикой будет группировать алерты по приоритету: критические (сервис недоступен, качество резко упало) — сразу будить ответственных людей, менее срочные — писать в рабочий мессенджер или тикет-систему для разбора в плановом порядке.

Важно не перегрузить себя ложными тревогами. Настраивайте алерты осмысленно, чтобы не возникало «шума» — когда оповещения сыплются по мелочам, их быстро перестают воспринимать всерьёз. Лучше начинать с нескольких самых важных правил: недоступность сервиса, превышение времени ответа, аномальное падение качества модели. Остальное можно постепенно добавлять и тюнить пороги по мере накопления опыта. Помните, цель алертинга — не создавать новых проблем, а помогать вам оперативно реагировать на существующие.

Лучшие практики для стабильной работы AI-сервисов

Помимо метрик, дашбордов и алертов, есть ещё ряд приёмов, которые помогают поддерживать AI-модели в продакшене без сбоев. Рассмотрим наиболее полезные из них.

Логирование — ваш друг

Не ограничивайтесь одними метриками — подробные логи сервиса не менее ценны. Логирование даёт «чёрный ящик» событий, который очень выручает при расследовании инцидентов. Записывайте ключевую информацию о запросах: время, параметры входных данных, версию модели, результат предсказания, и, конечно, ошибки (стектрейсы). Это не значит, что нужно захламлять логи персональными данными пользователей или гигабайтами входов — но общие сведения и идентификаторы помогут воспроизвести ситуацию. Например, если по метрикам вы увидели всплеск ошибок после полуночи, вы полезете в логи и сразу найдёте там, скажем, исключение OutOfMemory или некорректный формат входного JSON — то, что и стало причиной проблемы. Хорошая практика — централизовать сбор логов (ELK/EFK-стек либо облачные аналоги), чтобы можно было быстро поискать по всем инстансам сразу. Логи дополняют метрики: метрика покажет факт проблемы, а лог — контекст и детали.

Отслеживание версий моделей

В динамичной среде MLOps модели могут обновляться часто — новые эксперименты, улучшенные алгоритмы, дообучение на свежих данных. Чтобы не запутаться и иметь возможность отката, версируйте модели. Присваивайте каждой развёрнутой модели явный номер версии (например, v1.3.5). Упоминайте эту версию в метриках и логах. Тогда, когда метрика качества начала падать, вы сразу видите: ага, проблема появилась после деплоя версии v1.3.5 — вернём временно v1.3.4 и разберёмся. Более того, версионирование даёт прозрачность: команда, бизнес и клиенты (внутренние или внешние) знают, какая версия алгоритма сейчас работает. Используйте инструменты вроде MLflow, DVC или просто аккуратное хранение артефактов с понятными именами — главное, чтобы был порядок. Отслеживая версии, вы избегаете ситуации «не знаю, какая модель сейчас на проде», и облегчаете себе жизнь при любом расследовании или сравнении.

Мониторинг дрейфа данных и модели

Мы уже упоминали дрейф модели — ту самую постепенную «усталость» модели от новых реалий. Это не мгновенная ошибка, а коварное явление: модель может работать всё хуже, но без явных сбоев, просто выдавать менее точные результаты, а вы об этом можете не сразу узнать. Поэтому настройте мониторинг дрейфа. Сравнивайте распределения новых входных данных с теми, на которых модель обучалась: статистики по признакам, доли классов, средние значения. Хорошая идея — периодически сохранять выборки входных данных и пропускать их через инструмент вроде Evidently AI или собственные скрипты статистического сравнения. Также следите за дрейфом предсказаний: например, если ваша модель классификации раньше выдавала положительный класс в 5% случаев, а теперь вдруг в 20% — что-то явно изменилось либо в данных, либо в самой системе. Это сигнал копнуть глубже. Автоматизировав такие проверки, можно строить метрики «distance» или «divergence» и даже навесить алерты на них. В итоге дрейф не застанет вас врасплох: вы будете видеть тренд и вовремя спланируете дообучение модели или пересмотр данных. Бизнесу это особенно важно: представьте, что модель скоринга кредита начинает ошибаться из-за изменений в экономике — мониторинг подскажет, что пора обновить алгоритм, прежде чем банк понесёт убытки.

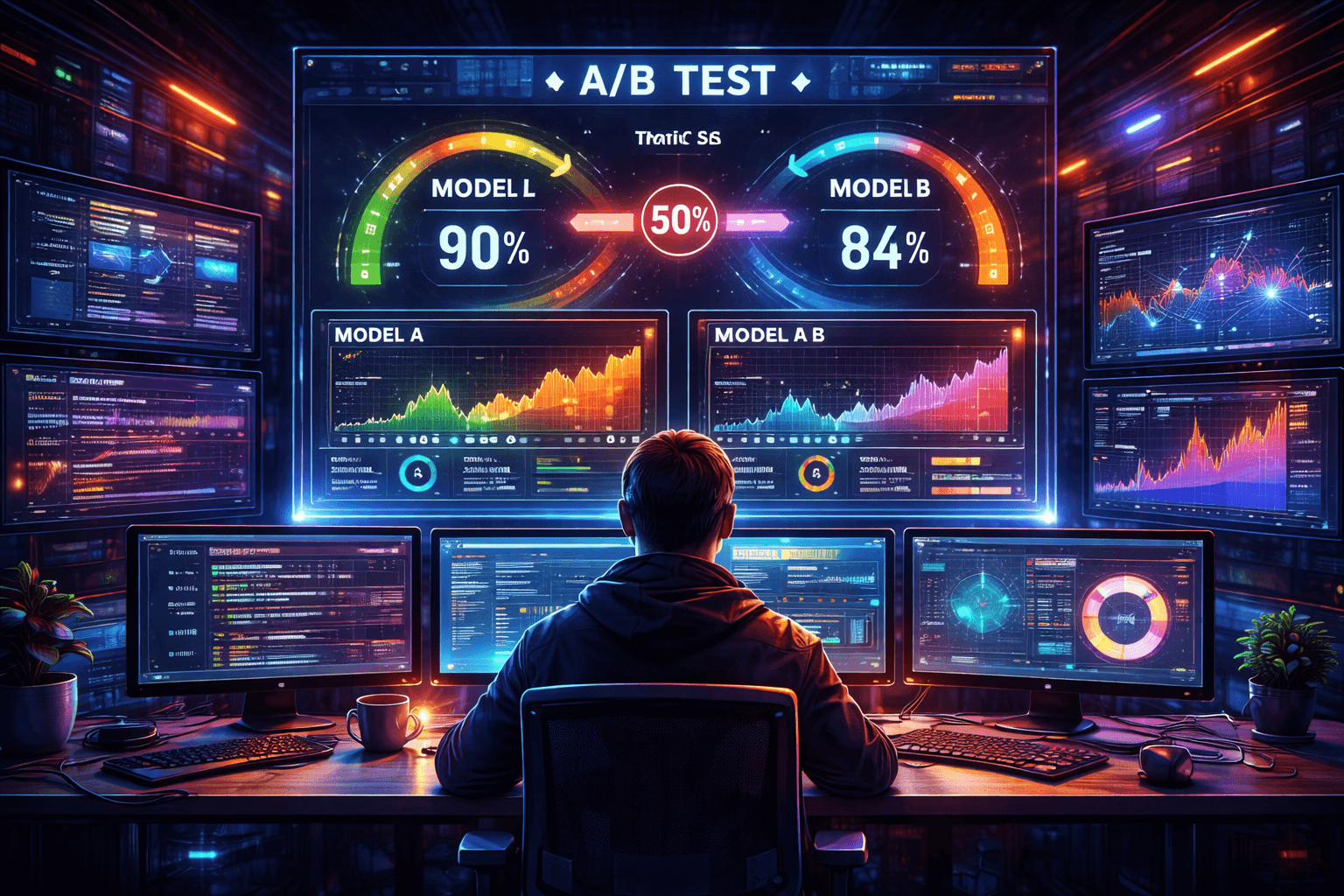

Эксперименты и A/B-тестирование

Применительно к ML это означает: не выкатывайте сразу новую модель на весь трафик. Сначала протестируйте её на небольшом проценте пользователей или в теневом режиме. Например, у вас есть старая модель версии v1 и новая v2, которая по тестам лучше. Вместо того чтобы заменять первую на вторую одномоментно, сделайте следующее: отправляйте 5% пользовательских запросов на модель v2, а 95% — по-прежнему на v1. Параллельно собирайте метрики по обеим. Сравните: подтверждается ли в реальных условиях, что v2 лучше по качеству? Не возросло ли время ответа? Как пользователи реагируют? Если всё хорошо — увеличиваем долю трафика на v2 постепенно до 100%.

Если же видим, что новая модель ухудшила метрики (бывает и такое — в офлайне на тестовых данных она была хороша, а в продакшене вскрылись нюансы), то трафик возвращаем на v1 и спокойно дорабатываем v2, никто кроме команды даже не заметит проблем. Это и есть отказоустойчивость на уровне процессов: вы не ставите всё на кон одним релизом. Компании-гиганты вроде Netflix и Amazon так и делают — новые алгоритмы сначала гонят на малой доле аудитории и только убедившись в успехе, распространяют на всех. Возьмите на вооружение этот подход, и ночной сон станет крепче: вы будете уверены, что внезапный "плохой" релиз модели не угробит сразу весь сервис.

Реализация на серверах King Servers

Все описанные методы и инструменты вполне можно реализовать на инфраструктуре King Servers. Во-первых, нужна серьёзная вычислительная мощность. Проще говоря, необходимы мощные сервера для AI, способные выдерживать высокую нагрузку. King Servers предоставляет современные выделенные серверы и облачные VPS с поддержкой GPU, которые отлично подходят для размещения ML-моделей и сопутствующих сервисов. Например, модель можно запустить на GPU-сервере, чтобы обеспечить ей быструю обработку вычислений (это напрямую влияет на время отклика и производительность ML-систем). Рядом вы можете развернуть мониторинг: установить Prometheus и Grafana на отдельной виртуальной машине или даже на том же сервере, если ресурсы позволяют.

Во-вторых, гибкость настройки. На серверах King Servers вы не ограничены в выборе инструментов: можно развернуть любой нужный софт — от Node Exporter для системных метрик до специализированных агентов вроде Evidently для анализа данных. К слову, у King Servers есть готовые образы и инструкции (например, по установке связки Prometheus+Grafana на Ubuntu) — это серьёзно ускорит старт мониторинга. А если времени разбираться нет, всегда можно обратиться к услуге администрирования: опытные специалисты помогут настроить окружение, оптимизировать параметры и интегрировать мониторинг по лучшим практикам.

Наконец, надёжность самой инфраструктуры. Мониторинг не даст пользы, если сервер, на котором он крутится, ненадёжен. С дата-центрами King Servers вы получаете стабильную связь и круглосуточную поддержку. Ваш AI-сервис будет под присмотром: даже если что-то случится на уровне железа, техническая команда сразу примет меры. Таким образом, используя возможности King Servers, вы можете построить полностью контролируемую среду: мощные серверы для AI, на которых крутятся ваши модели, плюс выстроенная по вашим требованиям система мониторинга и алертинга. Это даст уверенность, что каждый компонент — от модели до оборудования — работает как надо и не подведёт в критический момент.

Заключение

В продакшене нет мелочей — особенно когда речь о сервисах с искусственным интеллектом. Реального мира не волнует, насколько гениален ваш алгоритм, если он внезапно «упал» или выдаёт чепуху, потому что изменились данные. Поэтому мониторинг AI-сервисов — не опция, а необходимость для любой серьёзной команды DevOps/MLOps. Настройте контроль ключевых метрик, следите за здоровьем модели и инфраструктуры, вовремя получайте оповещения и реагируйте на них. Мы рассмотрели и скорость ответа, и ресурсы, и качество модели, и даже тонкости вроде дрейфа — все эти аспекты вместе позволяют взглянуть на вашу ML-систему под разными углами и не упустить надвигающиеся проблемы.

Не стоит пугаться объёма работы: начать можно с малого. Поднимите Grafana и Prometheus, выведите на графики несколько основных показателей — вы удивитесь, сколько нового узнаете о поведении своей модели в реальных условиях! По мере развития проекта подключайте и продвинутые штуки: мониторинг дрейфа, умный алертинг, экспериментальные выкаты. Главное — начать и делать шаг за шагом.

Ваши пользователи, да и вы сами, заслуживаете, чтобы AI-сервис работал стабильно, предсказуемо и прозрачно. Настройте мониторинг — и спите спокойно.

А команда King Servers всегда готова помочь с инфраструктурой и экспертизой, чтобы ваши идеи в области AI работали без сбоев. Включайте приборы, и пусть ваш проект летит к успеху на всех парах!