Оглавление

Сбор и хранение сырых данных

Представьте, что у вас есть богатое месторождение данных – настоящее золото современного бизнеса. Но без правильной обработки эти данные подобны сырой нефти: ценны, но бесполезны до переработки. Решение – пайплайн машинного обучения: выстроенный шаг за шагом конвейер, превращающий сырой поток информации в работающую ML-модель с реальной отдачей. Более того, если запустить такой конвейер в облаке, можно получить гибкость и масштабируемость, о которых раньше приходилось только мечтать. В этой статье мы на живом примере разберем, как построить такой конвейер данных в облачной среде – от сбора сырых данных до деплоя модели как API-сервиса. Будет и дружелюбный тон, и экспертные подсказки, метафоры и реальные аналогии – так что устраивайтесь поудобнее, будет интересно!Пример связи этапов ML-пайплайна с процессами разработки и эксплуатации (MLOps). Модель разрабатывается и обучается (ML), интегрируется в инфраструктуру (Dev), и затем поддерживается в продакшене (Ops), образуя непрерывный цикл.

Очистка и предобработка данных

Любой конвейер данных для машинного обучения начинается с исходного материала – данных. Это как собрать все ингредиенты перед готовкой сложного блюда. Данные могут поступать отовсюду: логи веб-сервисов, транзакции в базе, изображения с камер или даже показания датчиков IoT. Главная задача на этом этапе – собрать полный и качественный датасет, не потеряв важных кусочков по дороге. Например, если вы строите модель для интернет-магазина, вам понадобятся и данные о продажах, и сведения о товарах, и поведение пользователей на сайте. Сбор данных – процесс кропотливый: стоит убедиться, что данные разнообразные и релевантные, а также соблюдать юридические нормы (например, [GDPR] для персональных данных).

После сбора встает вопрос хранения. Хранить горы сырой информации на ноутбуке – плохая идея. Здесь на помощь приходит облачная инфраструктура. Облако предоставляет надежное хранилище, которое масштабирется под ваш объем данных и обеспечивает доступ 24/7. Представьте склад неограниченного размера, где ваш ценный сырье не потеряется и не испортится. В зависимости от структуры данных, выбирают разные решения: для неструктурированных потоков отлично подходят озера данных (data lakes) на базе облачного объекта хранилища (например, Amazon S3 или аналоги). Если данные структурированные (таблицы, отношения), можно использовать облачные базы данных – SQL или NoSQL, в зависимости от задач. В облаке легко развернуть нужный тип хранилища: от распределенной файловой системы до колоночного хранилища данных, все по щелчку, без покупки оборудования. Таким образом, мы собираем наши "ингредиенты" и складываем их на облачную кухню, готовые к дальнейшей готовке.

Пример-жизнь: Представьте стартап, собирающий данные о пользователях мобильного приложения. Сырые логи ежеминутно летят в облачное хранилище – так, команда не беспокоится, что данные затрутся или места не хватит. Когда придет время готовить модель, все нужное уже под рукой, аккуратно сложено и ждет своей очереди.

Готовы перейти на современную серверную инфраструктуру?

В King Servers мы предлагаем серверы как на AMD EPYC, так и на Intel Xeon, с гибкими конфигурациями под любые задачи — от виртуализации и веб-хостинга до S3-хранилищ и кластеров хранения данных.

- S3-совместимое хранилище для резервных копий

- Панель управления, API, масштабируемость

- Поддержку 24/7 и помощь в выборе конфигурации

Результат регистрации

...

Создайте аккаунт

Быстрая регистрация для доступа к инфраструктуре

Очистка и предобработка данных

Сырые данные редко бывают идеальными. Как нефть требует очистки от примесей, так и датасет нужно тщательно подготовить, прежде чем скормить его алгоритмам ML. Очистка и предобработка данных – этап, где данные превращаются из хаотичного набора в качественное топливо для модели. Что сюда входит? Удаление дублей и выбросов, заполнение или удаление пропущенных значений, приведение форматов к единому стандарту, нормализация чисел, кодирование категорий – всего не перечислить. Если в колонке возраста где-то написано "не указан", а где-то ноль – эти случаи надо обработать, иначе для модели это разные вещи. Предобработка может включать даже более хитрые приемы, например feature engineering – создание новых признаков из исходных данных, которые улучшат обучение модели (скажем, извлечь признак "время дня" из отметки времени покупки).

Важно, что обработка данных должна быть воспроизводимой и автоматизированной. Здесь часто на выручку приходит язык Python для машинного обучения – с его библиотеками (Pandas, NumPy и др.) вы можете написать скрипты очистки, которые легко запускать снова и снова. А если данных действительно много (миллионы записей или больше), то на сцену выходит обработка больших данных – например, с помощью Apache Spark или Hadoop, которые параллельно пережуют огромные объемы и выдадут очищенный результат. Облачная инфраструктура опять облегчает жизнь: вместо того чтобы покупать десятки серверов для кластера Spark, вы просто запускаете кластер в облаке на нужное время. Через час он справится с гигабайтами информации и автоматически свернется, если больше не нужен. Гибкость и экономия налицо.

Аналогия: Представьте научную лабораторию, где у вас в пробирках смесь всего подряд. Очистка данных – как серия фильтров и реакций, отделяющих ценные вещества от шума. К концу этого этапа у вас "химически чистые" данные, готовые вступить в модель как реагент. Автоматизация же предобработки сродни конвейеру на заводе: никакой ручной возни с каждой пробиркой – все протекает по заданным трубопроводам шаг за шагом.

Автоматизация конвейера: оркестрация с Apache Airflow и Kubeflow Pipelines

Теперь, когда мы умеем собирать и чистить данные, встает вопрос: как запустить весь этот процесс на регулярной основе и без ручного участия? Вручную протягивать данные через каждый этап – все равно что каждый раз собирать конвейер заново. Вместо этого настраивают автоматизацию ML-пайплайна. Это как настроить автопилот: вы задаете последовательность действий, а система сама их выполняет в нужном порядке, вовремя и без ошибок. В мире Data/ML-инженеров есть целый класс инструментов, называемых оркестраторами рабочих процессов. Их задача – управлять выполнением задач (job'ов), следить за зависимостями и расписанием, автоматически запускать скрипты и сервисы, когда приходит время.

Одним из самых популярных решений является Apache Airflow – открытая платформа, позволяющая программировать и планировать сложные конвейеры данных. Вы описываете pipeline в виде DAG (ориентированного ацикличного графа) с шагами: например, шаг сбора данных, затем шаг предобработки, потом обучение модели. Airflow управляет, чтобы каждый шаг выполнился в нужной последовательности, перезапустит его при падении, запишет логи – красота! Например, можно настроить, чтобы обучение модели запускалось раз в неделю автоматически ночью – Airflow сам проследит, чтобы к тому времени свежие данные уже собрались и подготовились предыдущими задачами. Этот инструмент уже стал де-факто стандартом для автоматизации ETL и ML-конвейеров, а в облаке его можно развернуть за минуты. Многие облачные провайдеры даже предлагают managed Airflow (управляемые сервисы), где вам не нужно заботиться о настройке серверов для него – просто пишете свои DAG и запускаете.

Другой яркий пример – Kubeflow Pipelines. Это часть открытой платформы Kubeflow от Google, заточенная под оркестрацию ML-конвейеров в Kubernetes. Звучит громоздко, но идея проста: если ваши задачи (шаги пайплайна) упакованы в контейнеры (Docker), Kubeflow Pipelines позволит запускать их на кластерe Kubernetes легко и с масштабированием. Представьте конвейер, где каждый этап – это отдельный контейнер (например, один со скриптом очистки, другой с кодом обучения модели), а Kubeflow управляет их исполнением и передачей данных между ними. В итоге вы получаете мощную систему, идеально вписывающуюся в облачную инфраструктуру: можно хоть каждую задачу запускать на отдельной машине, если нужно, а Kubernetes будет следить за ресурсами. Плюс Kubeflow включает дополнительные плюшки для ML: встроенное отслеживание экспериментов, возможность тонкой настройки гиперпараметров (через модуль Katib), и даже свой сервис для деплоя моделей (KFServing). Если Apache Airflow – это универсальный планировщик для любых задач, то Kubeflow Pipelines заточен именно под ML Ops сценарии, ближе к данным и моделям. Оба инструмента дополняют друг друга, и выбор часто зависит от инфраструктуры: нет ли у вас готового Kubernetes-кластера или предпочтений команды.

Важно, что автоматизация ML-процесса – ключевой принцип MLOps. Это позволяет инженерам сосредоточиться на экспериментах и улучшении модели, пока автоматизация ML берет на себя рутину перемещения данных и запуска вычислений. Облачная среда еще более упрощает все это: вы можете вынести конвейер в облако и не думать об администрировании серверов для Airflow или Kubernetes – провайдер сделает это за вас. К тому же, облако позволяет легко масштабировать конвейер: пришло больше данных – добавились новые серверы на лету, упала нагрузка – лишние ресурсы отключились. В итоге ваш ML-конвейер работает как слаженный оркестр, а вы выступаете дирижером, задающим партитуру.

Мини-кейс: Компания анализирует поведение пользователей на своем сайте и хочет обновлять модель рекомендаций ежедневно. Раньше анализом данных занимался специалист вручную раз в месяц – медленно и с задержками. Внедрив Apache Airflow, команда настроила ежедневный ночной запуск пайплайна: данные за день собираются (шаг 1), очищаются скриптами (шаг 2), затем модель переобучается на свежих данных (шаг 3) и метрики записываются в отчёт (шаг 4). Утром бизнес получает обновленные рекомендации, пока инженеры пили кофе. Автоматизация не только сэкономила десятки часов работы, но и сделала сервис более адаптивным к новым данным.

Обучение модели

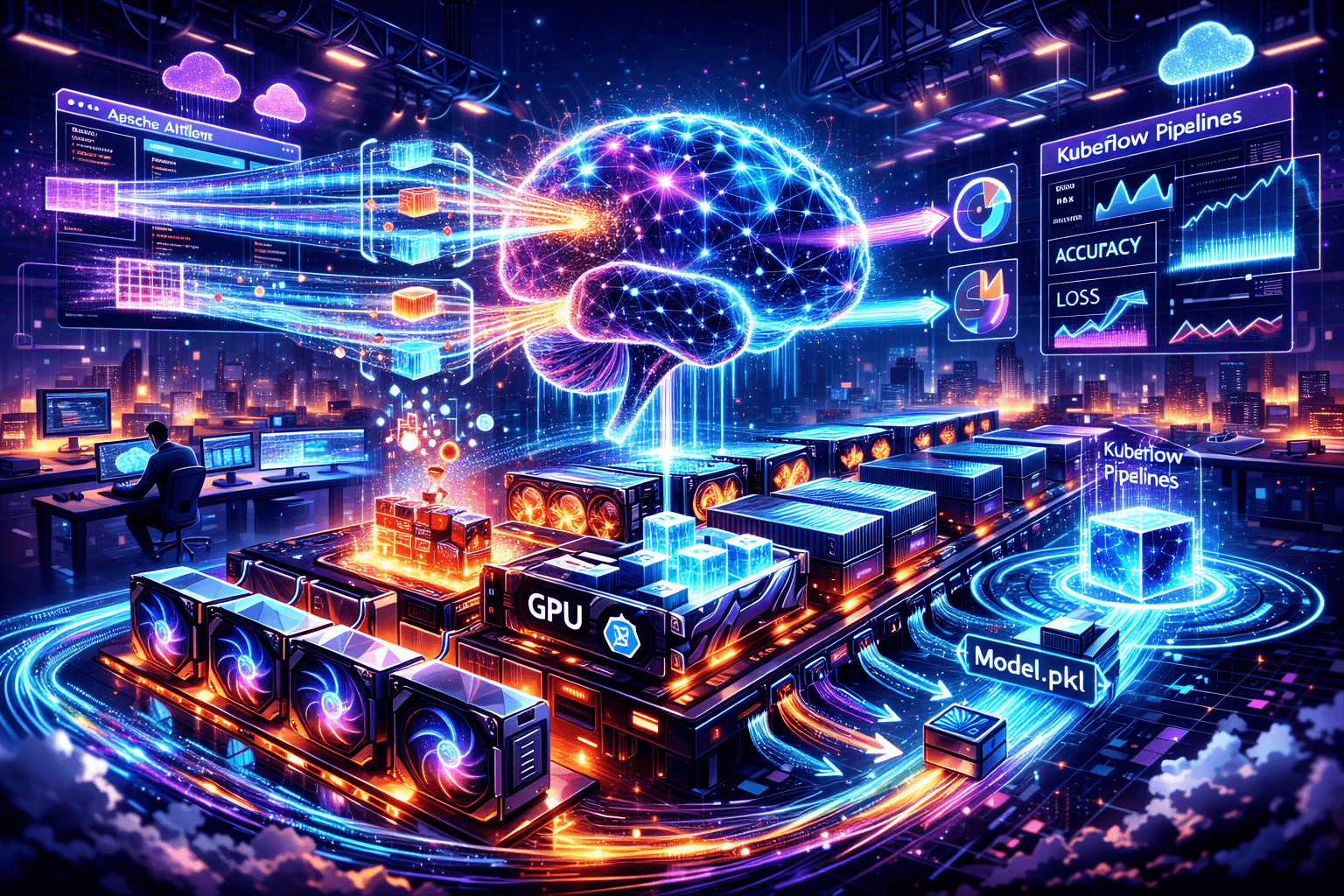

Когда данные готовы и конвейер налажен, наступает звёздный час – обучение модели. Это сердце всего ML-проекта, где алгоритм черпает знания из данных. Продолжая нашу аналогию, мы наконец запускаем станок, который из очищенного сырья производит готовый продукт – модель машинного обучения. Практически, обучение сводится к тому, чтобы взять подготовленный датасет, выбрать подходящий алгоритм или архитектуру модели и "кормить" модель данными, чтобы она настроила свои параметры. Например, это может быть градиентный бустинг решающих деревьев, нейронная сеть или даже простой линейный регрессор – выбор зависит от задачи.

Важный момент: обучение часто итеративный процесс. ML-инженер пробует разные подходы, меняет гиперпараметры, экспериментирует с признаками. В этом помогает отслеживание экспериментов: инструменты вроде MLflow или даже простое логирование результатов каждого прогона. Но даже запустив обучение в рамках конвейера, нужно подумать о ресурсах. И вот опять облако играет на нашей стороне. Нужна мощная видеокарта (GPU) для ускорения обучения нейросети? Не проблема – в облаке можно арендовать виртуальный сервер с необходимой GPU на часы или дни, пока идет обучение, вместо покупки дорогого оборудования. Если данных очень много и модель обучается долго, можно распараллелить задачу – например, использовать распределенное обучение на нескольких машинах одновременно. Облако предоставляет готовые решения для этого, от управляемых сервисов (AWS SageMaker, Azure ML, GCP AI Platform) до возможности поднять свой кластер и запустить распределенные вычисления. Масштабирование – вот козырь облачной инфраструктуры в обучении ML-моделей.

Кроме того, почти весь современный стек машинного обучения пишет код на Python. Это означает, что весь наш pipeline, включая этап обучения, легко интегрируется: скрипт на Python для обучения можно вызывать прямо из Airflow (операторы PythonOperator) или упаковать в Docker-контейнер для Kubeflow. То есть, если вы написали локально ноутбук train_model.ipynb и убедились, что модель учится, перенос его в облачный пайплайн не составит труда. В итоге, на этапе обучения мы получаем уже обученную модель (например, файл с весами нейронной сети или сериализованный объект модели model.pkl). Но радоваться рано – впереди не менее важные шаги.

Пример: Data Scientist обучает модель классификации клиентов по вероятности оттока. Сначала он пробует логистическую регрессию – получает 75% точности. Потом решает испробовать Random Forest – точность растет до 80%. Затем подключает нейронную сеть – 82%, но обучение дольше. Все эти эксперименты он ведет в облачной среде, используя Jupyter Notebook на удаленном сервере с GPU. Каждый прогон фиксируется в MLflow с параметрами и метриками. В конечном итоге лучший результат дает Random Forest с определенными гиперпараметрами. Этот код обучения интегрируют в ML-пайплайн, чтобы модель могла переобучаться автоматически на новых данных. Инженер доволен: облако позволило параллельно гонять несколько вариантов моделей, не заставляя ждать неделями, и победитель выбран наилучший из возможных.

Валидация модели

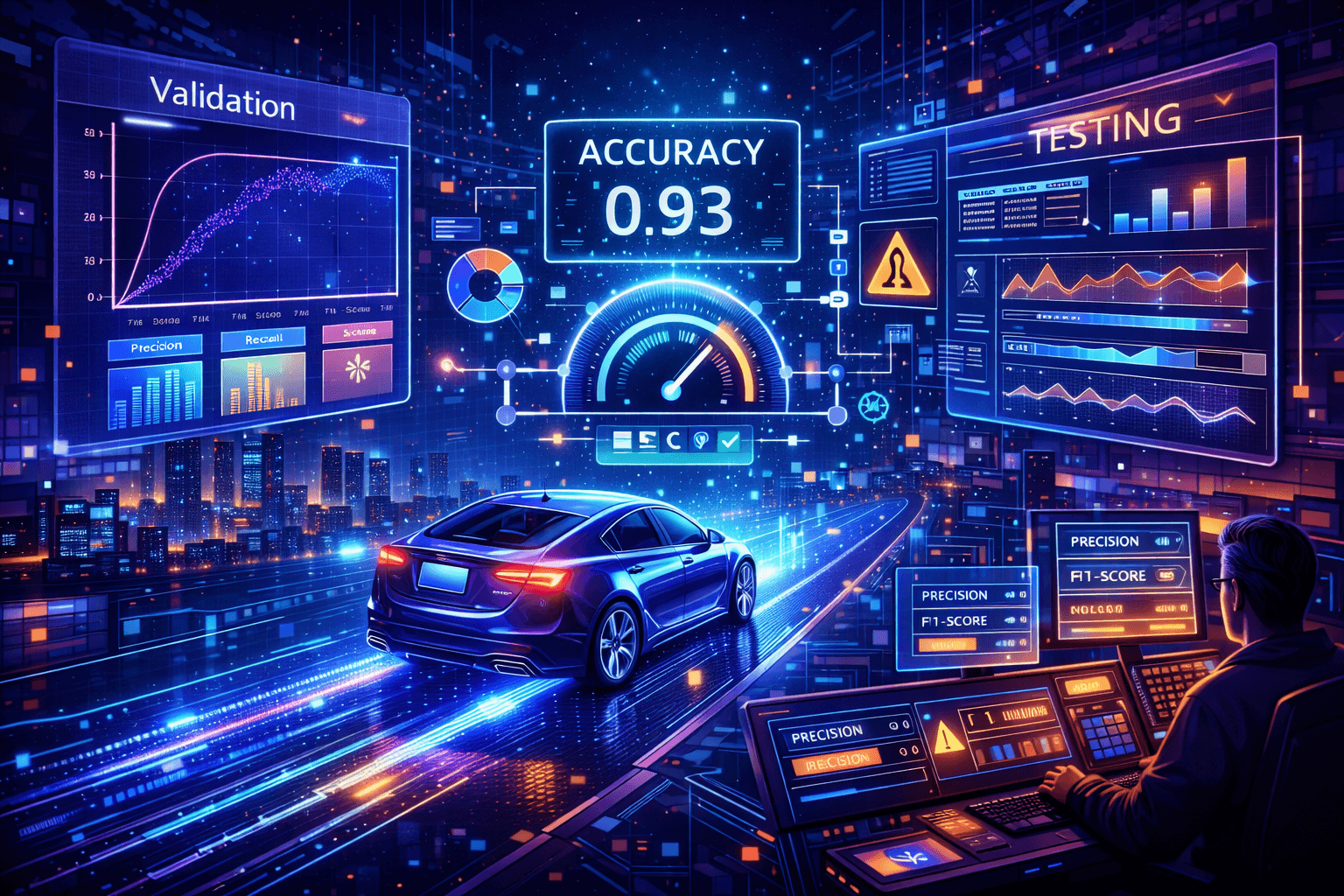

Прежде чем отправлять модель "в люди", ее нужно тщательно проверить – вдруг она ошибается чаще, чем хотелось бы, или имеет перекосы? Валидация модели – это как экзамен перед выпуском, финальное тестирование качества. На этом этапе мы оцениваем, насколько хорошо модель будет работать на новых, невиданных данных. Классический подход – отложить часть данных (т.н. тестовая выборка или validation set), которые не участвовали в обучении, и посмотреть, как модель справляется с этой проверкой. Метрики качества (точность, полнота, F1-score, RMSE – нужное подчеркнуть) расскажут, достигли ли мы цели. Например, если модель предсказывает отток клиентов, важно понять, скольких "ушедших" она правильно обнаруживает и сколько ложных тревог дает.

Хорошей практикой является кросс-валидация – это когда датасет разбивается на несколько частей и модель обучается и тестируется несколько раз на разных разбиениях. Это помогает убедиться, что качество модели стабильно, а не получилось случайно на одном разбиении. Кроме того, стоит обратить внимание на переобучение: если на обучающей выборке модель показывает 99% точности, а на тестовой – 60%, значит она переучилась на тренировочных данных и плохо обобщает результаты. В таком случае нужно шаг назад: изменить модель, улучшить предобработку или добавить данных.

В рамках нашего конвейера данных этап валидации может быть отдельной задачей. Например, после обучения модели скрипт автоматически прогоняет ее на тестовом наборе и сохраняет метрики в базу или файл. Эти метрики можно даже автоматически проанализировать: если качество ниже порога, конвейер может сигнализировать команде ("Alarm! Модель получилась слабовата"). В более продвинутых сценариях реализуют даже автоматическое сравнение моделей: новая модель разворачивается параллельно со старой и некоторое время их ответы сравниваются на реальных данных (техника A/B-тестирования или shadow deployment). Но это уже скорее про продакшен, а мы пока завершаем проверку в офлайне.

Важно отметить, что валидация – не разовая акция. В цикле MLOps модель постоянно мониторится и переоценивается уже после деплоя, но об этом чуть позже. Сейчас же, получив удовлетворяющие метрики на тестовом наборе, мы можем с уверенностью сказать: модель готова к боевому применению. Ну или, если не готова – мы знаем, что подкрутить, и запускаем еще круг обучения с улучшениями. ML-пайплайн гибкий: вы всегда можете вернуться на шаг назад, изменить данные или модель, и прогнать все снова. Автоматизация позволяет это сделать быстро, а не повторять все вручную.

Сравнение: Тестирование ML-модели похоже на контроль качества на заводе. Вот вы собрали автомобиль (натренировали модель) – не выпускаете же вы его сразу покупателю, не сделав тест-драйв? Конечно, нет: вы проверите тормоза, рулевое управление, проведете краш-тесты. В ML роль тормозов и краштестов выполняют метрики на отложенных данных и стресс-тесты на адекватность работы. Только убедившись, что "машина" едет и не разваливается, мы выпускаем ее на дорогу – то есть деплоим модель в продакшен.

Развертывание модели как API-сервис

И вот, модель обучена и проверена – настало время выпустить ее в большой мир. Развертывание модели (он же деплой модели) – это процесс, когда мы интегрируем модель в реальное приложение или сервис, чтобы ею могли пользоваться другие системы или пользователи. Чаще всего модель разворачивают в виде веб-сервиса с REST API, то есть модель становится доступна через запросы: отправил ей данные – получил предсказание. Именно так работают рекомендательные сервисы, фильтры спама, голосовые помощники – внутри них крутится модель, завернутая в API. Таким образом, мы получаем API-сервис модели, которым можно легко воспользоваться в любом приложении.

Как же превратить наш файл с моделью в работающий сервис? Один из самых простых путей – написать небольшой веб-сервер на Flask или FastAPI (для Python). Этот сервер при старте загружает модель в память, а затем в обработчике запроса (/predict например) принимает входные данные, передает их модели и возвращает результат клиенту. Такой подход часто применим на начальном этапе. Однако, если мы говорим о промышленном развертывании, понадобятся дополнительные шаги: контейнеризация, оркестрация, CI/CD.

Контейнеризация означает упаковать наше приложение (модель + веб-сервер) в Docker-контейнер. Зачем это нужно? Контейнер содержит в себе всю среду – зависимости, саму модель, код сервиса – и гарантирует, что у нас в продакшене все будет работать так же, как работало у разработчика на компьютере. "Работает на моем компе" перестает быть проблемой, когда вы деплоите контейнер. Кроме того, контейнеры удобнее масштабировать и мигрировать между серверами. В облаке для этого есть даже специальные сервисы: вы загружаете контейнер в реестр, а дальше можете разворачивать его на виртуальных серверах, в Kubernetes-кластере или использовать безсерверные услуги.

Говоря об оркестрации: если у вас серьезный проект, где моделью пользуются тысячи клиентов, вы не ограничитесь одним контейнером на одном сервере. Понадобится оркестратор контейнеров – и здесь снова на сцену выходит Kubernetes. Он автоматически управляет тем, сколько экземпляров сервиса с моделью запустить, перезапустит упавшие, распределит нагрузку между ними и даже сделает автомасштабирование в зависимости от трафика. Облачные платформы позволяют разворачивать Kubernetes кластеры (например, Amazon EKS, Google GKE, Microsoft AKS) или предлагают собственные средства масштабируемого деплоя (AWS Elastic Beanstalk, Azure App Service и пр.). Итог: ваша модель доступна круглосуточно, и сервис устойчив к нагрузкам – если вдруг наплыв пользователей, новые экземпляры поднимутся автоматически.

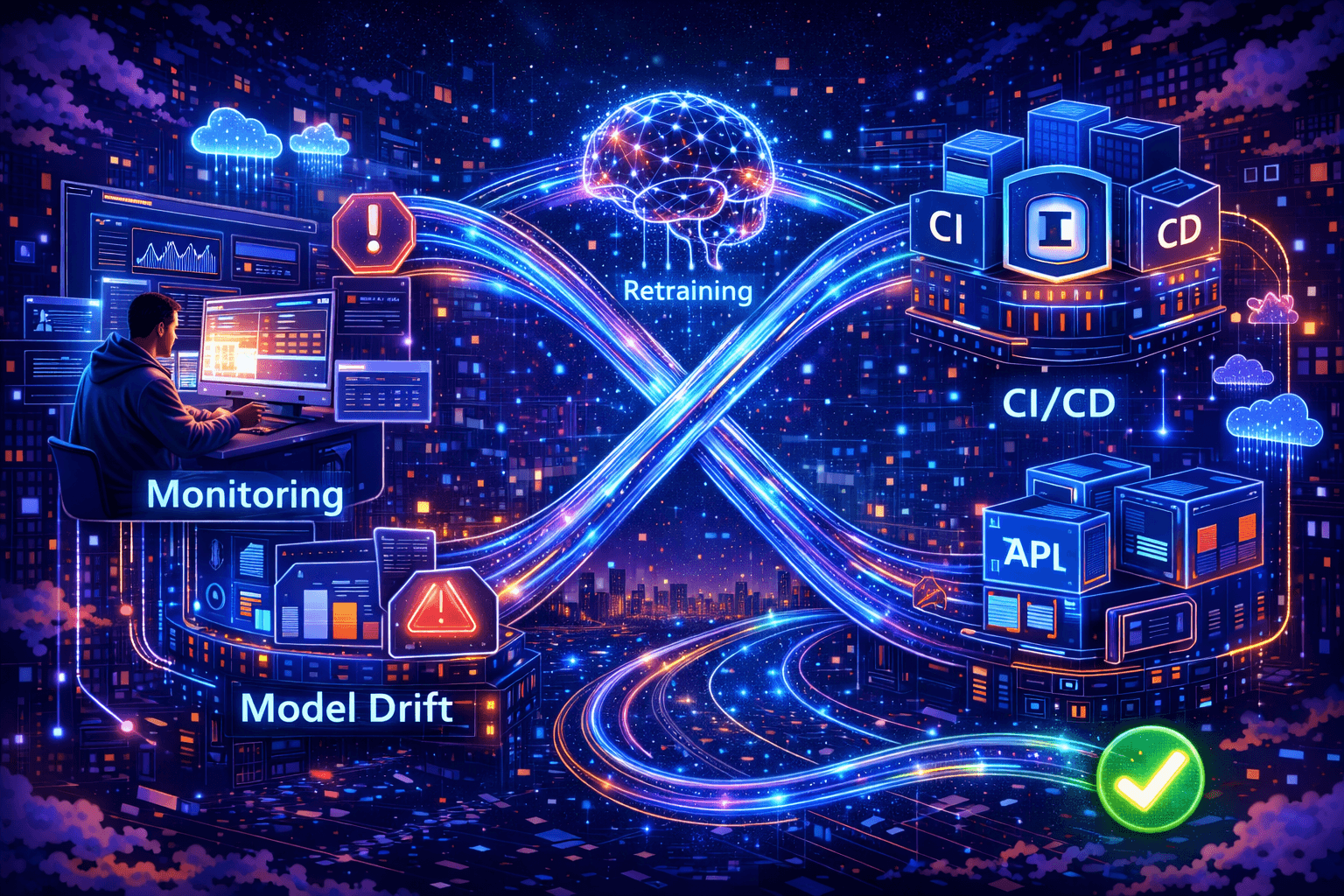

Теперь про CI/CD для моделей. Continuous Integration/Continuous Deployment – это непрерывная интеграция и доставка. В контексте ML это означает, что новые версии модели могут автоматически проходить тестирование и выкатываться в продакшен без длительных ручных процессов. Как это выглядит: представьте, что вы улучшили модель (например, добавили новые данные и переобучили). Система CI/CD (Jenkins, GitLab CI, GitHub Actions или аналогичная) подхватывает обновление кода/модели, запускает pipeline: прогоняет автоматические тесты (убедиться, что модель хотя бы запускается и дает приемлемые ответы), затем при успешных тестах контейнер с новой моделью деплоится на staging-среду. Там можно сделать дополнительную проверку или A/B тест. Далее нажатием кнопки (или автоматически) новая версия заменяет старую в продакшене – деплой модели завершен. Все это делается с минимальным простоем и рисками, благодаря автоматическим проверкам и поэтапному выкату. Практики DevOps отлично адаптируются к ML и дают нам необходимую скорость и надежность внедрения моделей. Недаром сейчас говорят про ML Ops – слияние машинного обучения с лучшими практиками эксплуатации.

Важно не забыть и про мониторинг уже развернутой модели. После деплоя нужно следить за ее качеством: собирать метрики (например, сколько запросов успешно обработано, какова средняя точность ответов со временем), отслеживать дрейф данных – не изменилась ли статистика входящих данных так, что модель начала хуже работать. Облачная инфраструктура дает инструменты для этого тоже: например, сервисы логирования и мониторинга (AWS CloudWatch, Google Cloud Monitoring и пр.), куда можно отправлять показатели и настроить оповещения. Если модель деградирует, MLOps-инженеры об этом узнают и смогут инициировать переобучение или улучшение.

Финальный аккорд (пример): Допустим, у вас есть модель, предсказывающая спрос на такси в городе. Вы решили развернуть ее как API-сервис, чтобы диспетчерское приложение запрашивало прогноз каждые 5 минут и направляло водителей в горячие точки. Вы написали на Python небольшой REST-сервер с эндпоинтом /predict, упаковали его вместе с моделью в Docker-образ. Затем вы настроили в облаке кластер Kubernetes из нескольких виртуальных серверов – это обеспечит бесперебойность. С помощью CI/CD вы автоматизировали обновление: как только данные за новый месяц поступают, pipeline обучает новую версию модели и автоматически через GitLab CI развертывает обновленный контейнер. В результате, ваш сервис всегда использует актуальную модель без долгих простоев, а если вдруг пользователей станет вдвое больше – Kubernetes сам поднимет дополнительные копии сервера. Клиенты довольны (машины подаются точно вовремя), бизнес счастлив (эффективность выросла), а вы можете немного выдохнуть перед новым циклом улучшений модели.

Вывод

Мы прошли путь от сырого набора данных до готового сервиса с моделью в продакшене. Этот пайплайн машинного обучения – как хорошо отлаженный механизм, где каждое звено на своем месте: данные собираются и хранятся в облаке надежно и масштабируемо, очистка и предобработка превращают их в чистое топливо, автоматизация пайплайна с помощью инструментов вроде Apache Airflow и Kubeflow Pipelines снимает рутинные задачи с плеч инженеров, модель обучается на мощностях облачной инфраструктуры (хоть на десятке GPU одновременно), валидируется как на экзамене, и, наконец, через контейнеризацию и CI/CD осуществляется бесшовный деплой модели в виде API-сервиса. Все этапы взаимосвязаны и подкрепляют друг друга – это и есть практическое воплощение ML Ops подхода, когда разработка модели и ее внедрение в продукт идут рука об руку.

Для ML-инженеров, дата-сайентистов и архитекторов решений такой подход обеспечивает спокойный сон: система сама позаботится о многих вещах – нужно лишь задать правильную архитектуру конвейера. Для клиентов облачного хостинга это тоже отличная новость: современные облачные решения (виртуальные серверы, контейнеры, управляемые базы и сервисы) делают передовые ML-пайплайны доступными даже для небольших команд. Больше не нужно строить инфраструктуру с нуля – достаточно арендовать нужные ресурсы и сразу фокусироваться на модели и данных.

В завершение хочется отметить, что построение конвейера данных для машинного обучения – это не разовый проект, а путешествие. Начать можно с малого: автоматизировать пару шагов, задействовать облако для хранения или обучения. Постепенно вы добавите новые сегменты: расширите автоматизацию, внедрите мониторинг, настроите более хитрые схемы деплоя. Главное – начать. Облачная инфраструктура и современные инструменты значительно облегчают этот путь, нужно лишь сделать первый шаг. Ваши данные уже ждут, так дайте же им шанс превратиться в ценные инсайты! Пусть ваш ML-проект зажжет зеленый свет светофора, и конвейер понесет новатора к новым открытиям и успехам. Удачи на этом пути и пусть все ваши модели в продакшене будут точными, устойчивыми и приносящими пользу!

Источник вдохновения: собственный опыт и лучшие практики индустрии, подкрепленные материалами сообществ и экспертов.