Оглавление

- Вступление

- llama.cpp и GGUF – что это и с чем их едят?

- Зачем запускать LLM на CPU: автономность, конфиденциальность и экономия

- Минимальные требования и пример конфигурации VPS

- Как запустить LLM-модель через llama.cpp (обзорно)

- Параметры и тонкости: добиваемся стабильной работы на CPU

- Чего ждать от CPU-инференса: ограничения и возможности

- Внутренние ассистенты в деле: кейсы использования

- Заключение

Вступление

Представьте, что у вашей команды есть собственный «ChatGPT», который работает внутри корпоративной сети, знает ваши данные и отвечает мгновенно – и при этом не требует ни облачных API, ни дорогих видеокарт. Звучит круто, правда? Сегодня это не фантастика: с инструментами вроде llama.cpp и форматом моделей GGUF запустить локальный LLM на обычном VPS возможно практически каждому. В этой статье мы разберём, как поднять локальный LLM без GPU на CPU‑сервере, зачем это может понадобиться бизнесу и что для этого нужно. Спойлер: современный VPS с хорошим CPU и достаточной памятью способен на небольшое чудо – превратиться во внутреннего AI-ассистента, работающего 24/7 на благо вашей команды.

llama.cpp и GGUF – что это и с чем их едят?

llama.cpp – это открытый проект (библиотека на C/C++), разработанный энтузиастом Георги Гергановым, который изначально позволил запускать LLaMA-модели от Meta на обычных компьютерах без GPU. Проще говоря, llama.cpp – это «движок» для запуска LLM на VPS или любом локальном устройстве, оптимизированный под CPU. Он умеет работать с различными современными моделями (LLaMA 2, Mistral, Vicuna и др.), используя особые оптимизации – прежде всего квантизацию. Квантизация сокращает разрядность чисел в модели (например, с 16 бит до 4–8 бит), существенно уменьшая размер модели и требуемую память, почти не жертвуя качеством ответа. Без этой техники даже небольшая 7-миллиардная модель потребовала бы десятки гигабайт VRAM, а благодаря квантизации её можно запустить хоть на ноутбуке или Raspberry Pi.

GGUF – это новый универсальный формат файлов моделей, разработанный командой llama.cpp в 2023 году. Если расшифровать аббревиатуру, получится GPT Generated Unified Format. По сути, GGUF – это эволюция прежнего формата GGML (Georgi Gerganov Machine Learning), только более гибкая и самодостаточная. В одном .gguf-файле упаковано вообще всё, что нужно для локального запуска LLM: сами веса нейросети, словарь токенизатора, параметры архитектуры, метаданные и прочее. Такой файл – словно «мозг в коробке»: бросаете его на сервер с llama.cpp – и модель сразу готова к работе, без дополнительных настроек. Это как переход от вороха разных файлов к одному ZIP-архиву: один стандарт – и никаких конфликтов версий. Недаром GGUF сегодня стал де-факто стандартом среди энтузиастов локального ИИ. Многие популярные модели (LLaMA 2, Mistral 7B, Falcon, GPT-J и др.) уже доступны в этом формате – качай и запускай.

Немного образной аналогии: GGUF для AI-моделей – что MP3 для музыки. Раньше большие модели были как Blu-ray диск – тяжёлые и требовательные к «железу». А GGUF-модель – как хорошо сжатый видеофайл: весит во много раз меньше и запускается почти везде, не теряя основного смысла. Проект llama.cpp сделал большие языковые модели портативными, «упаковал» их для работы на обычных процессорах. В результате ИИ словно спустился с облачных небоскрёбов на землю – прямо на ваш ноутбук или сервер в дата-центре.

Готовы перейти на современную серверную инфраструктуру?

В King Servers мы предлагаем серверы как на AMD EPYC, так и на Intel Xeon, с гибкими конфигурациями под любые задачи — от виртуализации и веб-хостинга до S3-хранилищ и кластеров хранения данных.

- S3-совместимое хранилище для резервных копий

- Панель управления, API, масштабируемость

- Поддержку 24/7 и помощь в выборе конфигурации

Результат регистрации

...

Создайте аккаунт

Быстрая регистрация для доступа к инфраструктуре

Зачем запускать LLM на CPU: автономность, конфиденциальность и экономия

Почему вообще стоит заморачиваться с локальным LLM без GPU, если есть облачные сервисы? Причины сводятся к трём главным вещам: безопасность данных, независимость и деньги.

Полный контроль и приватность. Держать ассистента внутри своей инфраструктуры – значит, ваши данные никуда «на сторону» не уходят. Компании уже обожглись на отправке чувствительной информации внешним ИИ-сервисам. Достаточно вспомнить случай, когда сотрудники Samsung нечаянно залили в публичный чатбот исходный код – и корпоративные секреты утекли в сеть. Собственный же LLM работает внутри периметра компании, без внешних подключений, что исключает утечки почти полностью. Вы сами решаете, чему учить модель и кто к ней имеет доступ. Для отраслей, где критична конфиденциальность (финансы, медицина, госслужбы), автономный ИИ – это не прихоть, а необходимость. Никаких рисков, что ваши вопросы или клиентские данные окажутся на чужом сервере.

Независимость и гибкость. Внешние AI-платформы накладывают ограничения – будь то лимиты по запросам, задержки из-за сети или просто недоступность сервиса. Своё решение избавляет от этих проблем: вы не зависите от чужого API и интернета вообще. Кроме того, свой ассистент можно донастроить под ваши задачи. Публичные модели типа GPT-4 обучены на всем подряд и не знают специфики вашего бизнеса. А внутреннего бота вы научите именно тому, что нужно вам – продуктовой базе знаний, внутренним инструкциям, нужным языкам. Например, юрфирма может дообучить модель на внутренних прецедентах – тогда ответы будут точны в контексте местных законов. Такой кастомизации от «чужого» ChatGPT не добиться. По сути, private LLM – это ваш личный эксперт, говорящий на языке вашей доменной области.

Снижение затрат. Наконец, экономика. Аренда или покупка мощных GPU – удовольствие не из дешёвых. Топовые облачные видеокарты типа A100 или H100 могут стоить сотни долларов в сутки при интенсивном использовании. CPU-серверы значительно доступнее: их ежемесячная стоимость на порядок ниже GPU-аналогов. Если ваши задачи позволяют обойтись CPU, это может дать серьёзную экономию. Особенно когда счёт запросов идёт на тысячи, и оплата каждого обращения к внешнему API (например, GPT-4) суммируется в приличную сумму. Конечно, за бесплатный сыр выдавать не будем – CPU-инференс не бесконечно масштабируем, и время инженеров тоже стоит денег. Но во многих случаях «прокормить» свой VPS выходит выгоднее, чем платить за каждый чих облаку. К тому же вы платите фиксировано за сервер и можете использовать модель сколько угодно – никаких ограничений по токенам. Как говорится, свобода стоит того.

Минимальные требования и пример конфигурации VPS

Итак, что же нужно, чтобы запустить частного LLM-ассистента на CPU? Хорошая новость: для базовых моделей хватит вполне обычного облачного сервера средних параметров. Рассмотрим минимальные ориентиры.

Процессор и потоки. Логика проста: чем мощнее CPU и чем больше ядер, тем лучше. LLM-инференс нагружает в основном все ядра параллельно, особенно при генерировании текста. Поэтому 4 ядра – это разумный минимум, на котором модель 7–13B уже заработает. 8 ядер дадут более плавную работу, особенно если несколько пользователей спросят бота одновременно. Однако интересный факт: скорость работы сильно зависит ещё и от пропускной способности памяти. В сообществе отмечают, что после определённого количества ядер производительность упирается в скорость RAM. Поэтому гнаться за 32 ядрами смысла нет, лучше сбалансировать CPU и память. Выбирайте современные процессоры с поддержкой AVX2/AVX512 – llama.cpp задействует эти инструкции для ускорения. В VPS от King Servers используются новейшие CPU Intel Xeon и AMD EPYC, которые отлично подходят для подобных задач.

Оперативная память. Главный прожорливый ресурс – это память (RAM), ведь модель целиком загружается в ОЗУ. Объём зависит от размера модели и степени её квантизации. Примерно ориентиры такие: для 7-миллиардной модели (7B) в 4-битном варианте достаточно 8 ГБ RAM (сама модель ~4 ГБ + буферы), для 13B модели лучше иметь 16 ГБ, для 30B – от 32 ГБ и выше. В одном эксперименте на VPS с 12 ГБ ОЗУ удалось запускать модель ~12B в 4-битном формате общим весом около 10 ГБ. То есть 12–13 млрд параметров – потолок для 12 ГБ памяти. Если планируете модель покрупнее или с контекстом 8k/16k токенов, не скупитесь на память – возьмите с запасом. В крайнем случае можно задействовать SWAP-файл на NVMe SSD (виртуальная память на диске), но это снизит скорость. Лучше сразу обеспечить модели место в быстрой ОЗУ.

Диск и трафик. Размер квантованной модели может достигать нескольких десятков гигабайт (например, LLaMA 2 70B в 4-бит может весить ~35–40 ГБ). Поэтому выделите достаточно места на диске под хранение моделей. NVMe SSD предпочтительнее – не только из-за свопа, но и для быстрой загрузки модели в память. Сетевой трафик понадобился бы только чтобы скачать модель из репозитория (HuggingFace или аналогичного) – далее работа идёт локально. На всякий случай проверьте, что ваш тариф не имеет жёстких ограничений по трафику или скорости интернета на VPS.

Пример конфигурации. Допустим, вы выбрали VPS с 4 vCPU и 16 ГБ RAM – такого хватит, чтобы комфортно запустить LLaMA 2 13B или подобную модель в 4-битном виде. Этого бота смогут дергать несколько сотрудников одновременно с приемлемой скоростью. Если нужно совсем бюджетно, можно стартовать и с 2 CPU / 8 ГБ для моделей поменьше (7B или специализированные 4–6B вроде GPT-J). Виртуальный сервер должен позволять установить современную 64-бит ОС (Linux Ubuntu/Debian или Windows Server – llama.cpp компилируется под обе). К слову, в King Servers доступны VPS на базовых тарифах, которые удовлетворяют этим требованиям – например, можно гибко выбрать нужное число ядер и объем памяти на процессорах Intel/AMD последнего поколения. То есть технически препятствий почти нет: даже недорогой облачный сервер способен тянуть private GPT.

Как запустить LLM-модель через llama.cpp (обзорно)

Теперь перейдём от теории к практике: как же поднять нашего внутреннего ассистента на CPU? Общий путь такой:

1. Получаем llama.cpp. Этот проект живёт на GitHub, и для его использования нужно скачать исходники и скомпилировать. Не пугайтесь, это очень просто. Достаточно выполнить в терминале на вашем сервере:

git clone https://github.com/ggerganov/llama.cpp cd llama.cpp make

Через минуту сборки у вас появится исполняемый файл – обычно это ./main (консольная утилита) и библиотеки. Llama.cpp не требует особых зависимостей, сборка проходит на любой системе с установленным компилятором. Если же вы предпочитаете питоновский интерфейс, можно установить llama-cpp-python через pip – это удобно для интеграции модели в ваши приложения. Но для базового запуска хватит и бинарника main.

2. Скачиваем модель в формате GGUF. Выберите LLM-модель под свои задачи. Для начала многие берут что-то вроде LLaMA 2 7B Chat или Mistral 7B – они относительно компактные, но уже умеют прилично отвечать. Отличный вариант для ассистента – модели с пометкой “Instruct”, натренированные отвечать на просьбы пользователя. Ищите готовые файлы .gguf на Hugging Face или в репозиториях TheBloke (энтузиаст, выкладывающий многие модели в разных квантах). Вам нужна версия, пригодная для CPU, чаще всего с именем, например: model-name.Q4_K_M.gguf или …Q5_1.gguf. Это обозначает вид квантизации – 4-бит или 5-бит, сбалансированный вариант для качества. Скачанный файл может весить от 3–4 ГБ (для 7B Q4) до 8–10 ГБ (13B Q5). Кладём этот файл в папку, откуда будете запускать модель (например, ./models). Кстати, формат GGUF самодостаточен – никаких отдельных “весов” и “словников” больше не нужно, всё уже внутри.

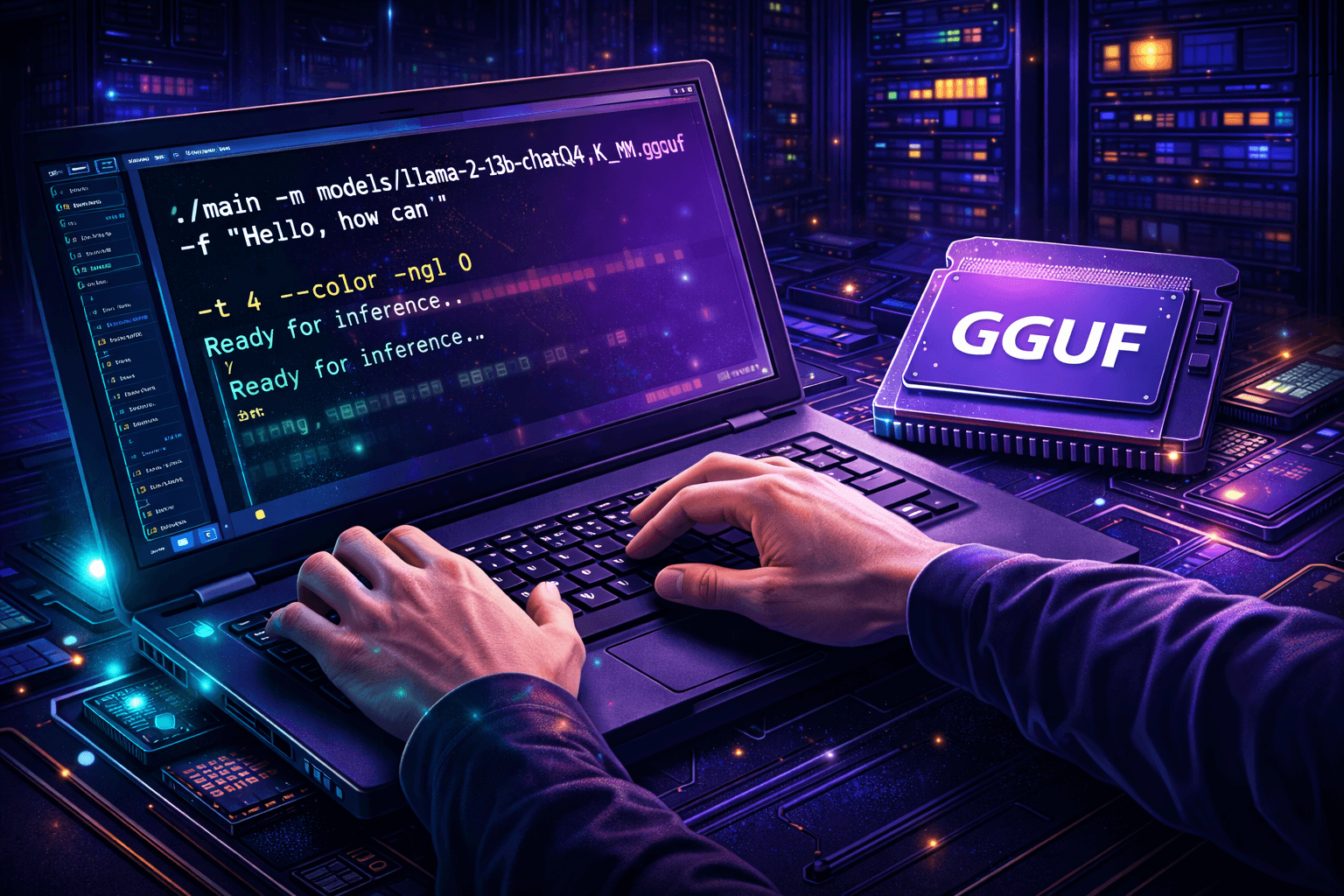

3. Запускаем inference через llama.cpp. Всё готово, можно попробовать задать первый вопрос модели! Команда запуска выглядит примерно так:

./main -m models/llama-2-13b-chat.Q4_0.gguf -p "Hello, how can I help you?" -n 100 -t 4 --color

Разберём ключевые параметры: - -m указывает путь к файлу модели GGUF. - -p задаёт prompt, то есть ввод пользователя (здесь простой пример на английском). Можно вместо строки указать файл с текстом через опцию -f filename. - -n 100 ограничивает генерацию 100 токенами (чтобы модель не «разбежалась»). - -t 4 ставит число потоков, обычно равное числу ядер CPU – так вы задействуете все ресурсы процессора для максимальной скорости. - --color просто раскрашивает диалог в консоли для удобства (необязательный эстетический флаг).

Когда вы нажмёте Enter, llama.cpp загрузит модель в память (может занять несколько секунд или минуту, в зависимости от размера) и затем выведет ответ модели прямо в консоль. Поздравляем, у вас запущен локальный LLM на VPS и отвечает на запросы! Далее можно экспериментировать: задавать новые вопросы, менять параметры генерации (температура, топ-p и проч.), или запустить скрипт chat.py из репозитория llama.cpp для интерактивного режима общения.

Обратите внимание: если ваша сборка llama.cpp поддерживает разные бэкенды (CUDA, OpenCL и пр.), и вдруг на сервере есть видеокарта, по умолчанию часть модели может попытаться грузиться на GPU. В контексте CPU-режима это не нужно, поэтому обычно используют флаг -ngl 0 (no GPU layers), чтобы явно запретить задействование GPU и работать только на процессоре. На чисто CPU-серверах это значение и так по умолчанию, но упомянуть стоит.

4. Настраиваем под себя. Запуск из консоли – это только начало. В реальной жизни вам, скорее всего, нужен либо веб-интерфейс для общения с моделью, либо API для интеграции в программы. Самый простой путь – обернуть llama.cpp в веб-интерфейс с помощью, например, Gradio или аналогов. Пара строк Python – и у вас открывается в браузере страничка, куда можно вводить запросы и получать ответы, как в ChatGPT. Для более серьёзной интеграции можно запустить модель как локальный сервер с API: существуют готовые обёртки, эмулирующие OpenAI API, но работающие с вашей моделью. Тогда ваши внутренние сервисы смогут делать HTTP-запросы к вашему ChatGPT, и все ответы будут генерироваться внутри компании. Выбор интерфейса – дело вкуса и задачи. На этапе тестов хватит и простого консольного или веб-чата; для продакшена же можно прикрутить авторизацию, логи запросов, интеграцию с корпоративным порталом или мессенджером (бывает удобно, когда бот сидит в Slack/Telegram и отвечает на вопросы там).

Параметры и тонкости: добиваемся стабильной работы на CPU

Хотя запустить модель – дело нехитрое, есть нюансы, которые помогут выжать максимум из вашего LLM на CPU. Рассмотрим главные настройки и ограничения.

Количество потоков (-t / --threads). Как уже упоминалось, оптимально выставить число потоков равным количеству ядер или аппаратных потоков (vCPU) вашего сервера. Если у вас 8 vCPU, смело ставьте -t 8. Это параллелит вычисления и значительно ускоряет генерацию ответа. Однако учтите: при 100% загрузке всех ядер система может откликаться медленнее для других задач. Виртуальный сервер под такие нагрузки лучше выделять отдельно, чтобы не мешать другим приложениям. Кстати, в некоторых случаях слишком большое число потоков не даёт выигрыш из-за ограничений памяти – экспериментально можно попробовать значения чуть меньше или больше и замерить скорость (tokens/sec). Но в целом llama.cpp сам хорошо масштабируется на все ядра.

Размер контекста (-c / --ctx_size). Этот параметр определяет, сколько токенов модель удерживает в «памяти разговора». Стандартно многие модели идут с контекстом 2048 токенов. Есть версии, расширенные до 4096, 8192 и даже 16384 токенов. Больший контекст полезен, если вашему ассистенту нужно скормить большой документ или вести длинный диалог. Но платой станет повышенное потребление памяти и более медленный вывод (ведь модель анализирует больше текста на каждом шаге). Например, LLaMA 2 13B с контекстом 4k «весит» около 8 ГБ, а с 16k – уже на несколько гигабайт больше. Рекомендуем выбирать контекст под реальные нужды: для кратких запросов хватит и 2048. Если требуется анализировать длинные тексты – берите модель с расширенным контекстом, но убедитесь, что на VPS хватит RAM.

Пакетная обработка (--n_batch). Менее очевидный, но важный параметр – так называемый batch size при обработке prompt. Он определяет, по сколько токенов за раз модель прогоняет при первичной обработке запроса. По умолчанию n_batch может быть ~8 или 16; увеличение этого значения (например, до 32 или 64) может ускорить этап ввода запроса в модель, особенно на многопоточных системах. Однако слишком большой batch потребляет больше памяти, и после определённого порога отдача снижается. Правило тут одно – если ваш prompt достаточно длинный (сотни или тысячи токенов), можно повысить --n_batch и замерить время обработки. Для коротких запросов это почти не играет роли.

Температура, частотная и пенальти повторов. Эти параметры (--temp, --repeat_penalty, --top_k, --top_p и др.) отвечают за креативность и разнообразие ответа. На качество содержания они не влияют, но могут помочь подстроить стиль бота. Например, --temp 0.7 сделает ответы более детерминированными и фактическими, а повышение до 1.0 добавит творческого разброса (но и шанс «галлюцинаций»). --repeat_penalty 1.1 или 1.2 иногда ставят, чтобы модель не повторялась. Внутреннему ассистенту обычно требуется точность больше, чем фантазия, поэтому температуру держат невысокой, а пенальти – умеренным. Эти параметры вы наверняка подберёте опытным путём под свою задачу, благо менять их легко, не перезапуская всю модель.

Мониторинг ресурсов. Запуская LLM на VPS, не забывайте контролировать нагрузку. Утилиты htop или docker stats (если в контейнере) покажут загрузку CPU и потребление памяти. Если видите, что памяти впритык или лезет в своп – лучше уменьшить размер модели или контекста. А если CPU постоянно забит на 100% и ответы идут медленно – подумайте об облегчении модели (другая квантизация) либо об увеличении числа ядер/тактовой частоты (масштабирование вертикально или переход на более мощный план). Также учтите: один instance модели может отвечать лишь на один запрос в каждый момент (если не городить сложный асинхрон). Поэтому для множества одновременных пользователей иногда запускают несколько копий модели на разных портах или машинах и распределяют запросы. Это уже вопросы оптимизации и оркестрации – на старте, скорее всего, одной модели хватит.

Чего ждать от CPU-инференса: ограничения и возможности

Теперь о реалиях: на что способен наш внутренний ассистент на CPU, и с какими ограничениями придётся смириться?

Прежде всего, скорость и параллелизм. Большие языковые модели на CPU работают заметно медленнее, чем на топовых GPU. Если на A100 можно генерировать десятки токенов в секунду, то CPU выдаёт считанные токены в секунду (зависит от модели и настроек). Для 7B модели на 4 ядрах можно ожидать порядка 5–10 токенов/сек, для 13B – 2–5 токенов/сек. Это означает, что ответ из ~200 токенов может формироваться несколько десятков секунд. В большинстве внутренних кейсов это не критично: подождать 10–30 секунд ответа – обычно нормально, ведь это всё локально и бесплатно. Но моментальные реакции как у облачных API здесь недостижимы, если только не взять топовый серверный CPU и небольшую модель. Решение: подбирать размер модели под желаемую скорость. Иногда 7B-модель, обученная под вашу задачу, даст больше пользы, чем 13B, которая думает дольше. CPU-LLM хорош для асинхронных задач и ботов “по запросу”, но не для чата с десятками сообщений в минуту. Также, как упоминалось, одна модель = один поток диалога. Если нужно обслуживать одновременно много запросов, может потребоваться горизонтальное масштабирование (несколько VPS с моделью за балансировщиком).

Качество ответов. Благодаря открытым исследованиям, качество небольших моделей постоянно растёт. Но всё же не ждите от локальной 7B того же уровня, что от облачного GPT-4. Ваш внутренний ассистент может отлично справляться с типовыми вопросами из документации, генерировать шаблонные письма, переводить тексты. Но на слишком творческие или сложные задачи (написание большого кода с нуля, решение запутанной головоломки) маленькая модель может отвечать слабее или бессвязнее. Эту проблему частично решают fine-tuning под конкретную задачу и расширение контекста (например, подключение вашей базы знаний через поиск). В корпоративной среде часто главное – чтобы модель знала именно ваши данные, даже если она не блещет общими энциклопедическими знаниями. В этом смысле узкоспециализированный 13B, обученный на ваших текстах, победит 70B, которая «не в курсе» ваших реалий. И всё же, если сравнивать head-to-head, топовые проприетарные модели пока превосходят доступные CPU-модели по универсальности. Относитесь к внутреннему боту как к помощнику для рутинных задач, а не как к всезнающему оракулу – тогда разочарований не будет.

Модельные ограничения. Когда вы работаете с квантованной моделью, важно понимать: сжатие – это компромисс. 4-битные модели могут иногда терять точность в сравнении с полными версиями. Кроме того, некоторые возможности (например, математика в уме, сложные логические рассуждения) у маленьких моделей развиты слабее. Они могут “галлюцинировать” факты – уверенно придумывать то, чего нет. В критичных сценариях (например, консультирование клиентов) стоит внедрять проверки ответов или ограничивать знаниями из утверждённых источников. Также учтите, что не каждую огромную модель вы вообще сможете запустить на CPU. Формально llama.cpp поддерживает и 70B, и даже 180B модели – но их работа на CPU может оказаться черепашьей. Представьте: 70 млрд параметров даже в 4-битном виде – это ~35 ГБ, и каждый токен требует десятков миллиардов операций. Без серьезного параллелизма это часы ожидания одного ответа. Так что практический потолок сегодня – это около 30B на одном сервере (и то лучше в 4-бит). К счастью, модели 7–13B уже научились многому, особенно после тонкой настройки. Если же нужен прорыв в качестве – никто не мешает начать с CPU-сервера, а потом, убедившись в пользе ассистента, перейти на более мощный GPU-сервер для ускорения.

Экспертиза и поддержка. Наконец, стоит понимать: развёртывание локального LLM – это немного R&D-процесс. В отличие от «включил и забыл» облачных решений, тут понадобится инженерное участие: подобрать модель, настроить окружение, отловить возможные баги (ну куда без них). Однако именно поэтому многие компании и выбирают свой путь – получают компетенции внутри команды. Локальный ассистент становится частью вашей инфраструктуры, и вы его улучшаете так, как считаете нужным. Сообществο вокруг llama.cpp достаточно большое – в сети полно гайдов, примеров и готовых скриптов, так что вы не одни. И, конечно, провайдеры тоже готовы помочь: например, специалисты King Servers всегда консультируют клиентов, как лучше развернуть те или иные сервисы на арендуемых серверах. Ваш успех с private LLM – в нашем общим интересе 😊.

Внутренние ассистенты в деле: кейсы использования

Чтобы не быть голословными, давайте посмотрим, что конкретно можно реализовать с помощью приватного LLM на CPU. Возможности здесь ограничены лишь вашей фантазией. Приведём несколько примеров, близких к реальным сценариям:

Кейс 1: Внутренний чат-бот для сотрудников. Представьте банк или большую IT-компанию, где сотни внутренних документов, процедур и регламентов. Новому сотруднику или даже опытному порой трудно быстро найти нужную информацию. Решение – обучить внутреннего чатбота на базе этих документов. Так, один крупный банк внедрил модель LLaMA 2 13B на сервере (кстати, у них как раз CPU-сервер, потому что решили сэкономить на GPU). Модель дообучили на внутренних руководствах и политике компании. Теперь сотрудники могут задать вопрос боту в стиле: «Как оформить отпуск за свой счёт?» или «Что делать при утере пропуска?», и получать мгновенный ответ с ссылкой на соответствующий раздел инструкции. Бот понимает именно внутреннюю терминологию, не путая значения слов, и всегда опирается на актуальные данные компании. Специалисты отмечают, что за первые месяцы использования такой ассистент сэкономил десятки человеко-часов: вместо долгих поисков по Wiki или мучения HR-ов простыми вопросами люди получают ответ за секунды. И при этом никакая конфиденциальная информация не выходит наружу – всё работает внутри защищённого контура.

Кейс 2: Помощник службы поддержки и DevOps. Другой пример – ассистент для техподдержки. В одной технологической компании сделали приватного бота на модели Vicuna-7B, развернув его на обычном VPS (8 vCPU, 16 GB RAM). Vicuna – это производная от LLaMA, хорошо подходит для диалогов. Бота подключили в корпоративный Telegram-чат, куда сотрудники могут написать, и он им ответит. Чему его обучили? Архив F.A.Q., база знаний по продукту, типовые тикеты из Jira – словом, всё, что накапливалось годами как опыт техподдержки. Теперь молодой специалист, столкнувшись с необычной ошибкой, может спросить бота: «Что значит ошибка с таким-то кодом?» – и в ответ получить совет или ссылку, как её решали раньше. Даже опытные инженеры пользуются: бот быстро напоминает команды, скрипты, настройки (например, «как настроить VPN для нашего датацентра» – и получает инструкцию). По отзывам, такая система разгружает лидов команды и ускоряет время реакции на инциденты. Да, модель всего 7B и работает на CPU, но её хватает, чтобы парсить вопросы и искать соответствующий ответ из обученных данных. Скорость практически в реальном времени, ведь запросов параллельно немного. Эффект – рост эффективности поддержки, более быстрое обучение новых сотрудников и вообще прикольный опыт взаимодействия с ИИ в повседневной работе.

Кейс 3: Генератор документов и шаблонов. В сфере e-commerce и продаж используют LLM для помощи в создании контента. Например, интернет-магазин может внедрить модель GPT-J 6B для генерации черновиков писем клиентам и описаний товаров. Один из наших клиентов как-то поделился историей: у них отдел поддержки часто рассылает типовые письма – про возвраты, про статус заказа, про акциями. Вместо того, чтобы менеджер каждый раз сочинял с нуля, сделали внутренний сервис на базе GPT-J (этот движок хорошо генерирует связанный текст на русском). Менеджер в веб-интерфейсе выбирает тип письма и вводит несколько фактов (имя клиента, номер заказа, что случилось) – а модель сама пишет вежливое грамотное письмо по шаблону, учитывая внутренний tone of voice. Осталось проверить и нажать «Отправить». В итоге тексты стали более унифицированными и на подготовку уходит 1–2 минуты вместо 10. И никаких проблем с тем, что данные клиентов уходят внешнему боту – всё локально. Подобный ассистент можно натаскать и на генерацию отчётов, резюме созвонов, шаблонов договоров – он берёт черновую работу на себя. Особенно ценят такое решение небольшие команды без выделенного копирайтера: ИИ-ассистент на CPU работает пусть не мгновенно, зато бесплатно и круглосуточно, экономя время сотрудников на рутине.

Разумеется, это лишь три примера. Ваша компания может найти свои уникальные сценарии. Главное – начать экспериментировать. Маленький шаг в виде прототипа на CPU может со временем перерасти в нечто большее, интегрированное во все бизнес-процессы.

Заключение

Эра, когда большие языковые модели были доступны только избранным с мощными GPU, уходит в прошлое. Сегодня запуск LLM на VPS без видеокарты – реальность, проверенная энтузиастами и уже приносящая пользу компаниям. Мы рассмотрели, что дают такие решения: это и контроль над данными, и гибкость в настройке, и экономия на постоянных платежах внешним сервисам. Да, чудес не бывает – потребуется выделить ресурсы (CPU-время, память) и усилия инженеров на настройку. Но взамен вы получаете собственного умного ассистента, обученного на ваших знаниях, работающего в нужном русле и доступного в любой момент. Он не устает, не забывает и со временем может становиться только лучше – стоит лишь подлить новых данных или обновить модель.

Хорошая новость: начать можно малой кровью. Попробуйте поднять тестовый экземпляр на имеющемся сервере или недорогом VPS – убедитесь в потенциале. Многие были удивлены, насколько пригодными оказались современные 7–13B модели в реальных задачах. Если результаты понравятся – масштабируйте решение, возможно, со временем перейдёте и на более мощное железо. Провайдеры вроде King Servers готовы помочь на каждом этапе. У нас вы найдёте любые конфигурации: от бюджетных VPS на CPU до производительных серверов с GPU – под любые нужды. Эксперты поддержки подскажут, какой вариант лучше для вашего кейса, помогут с развёртыванием, если понадобится.

В заключение хочется сказать: внутренний ассистент на CPU – это ваш первый шаг в будущее AI для бизнеса. Он показывает, что инновации доступны здесь и сейчас, что даже без космических инвестиций можно получить ощутимую пользу от ИИ. Так почему бы не попробовать? Мир AI стремительно меняется, и те, кто экспериментирует уже сегодня, завтра получат конкурентное преимущество. Берите идею на вооружение, играйтесь с моделями, вдохновляйтесь примерами – и, возможно, совсем скоро ваш собственный корпоративный «GPT» станет незаменимым сотрудником в вашей команде. Удачи на этом увлекательном пути в компании с King Servers и новыми возможностями ИИ!