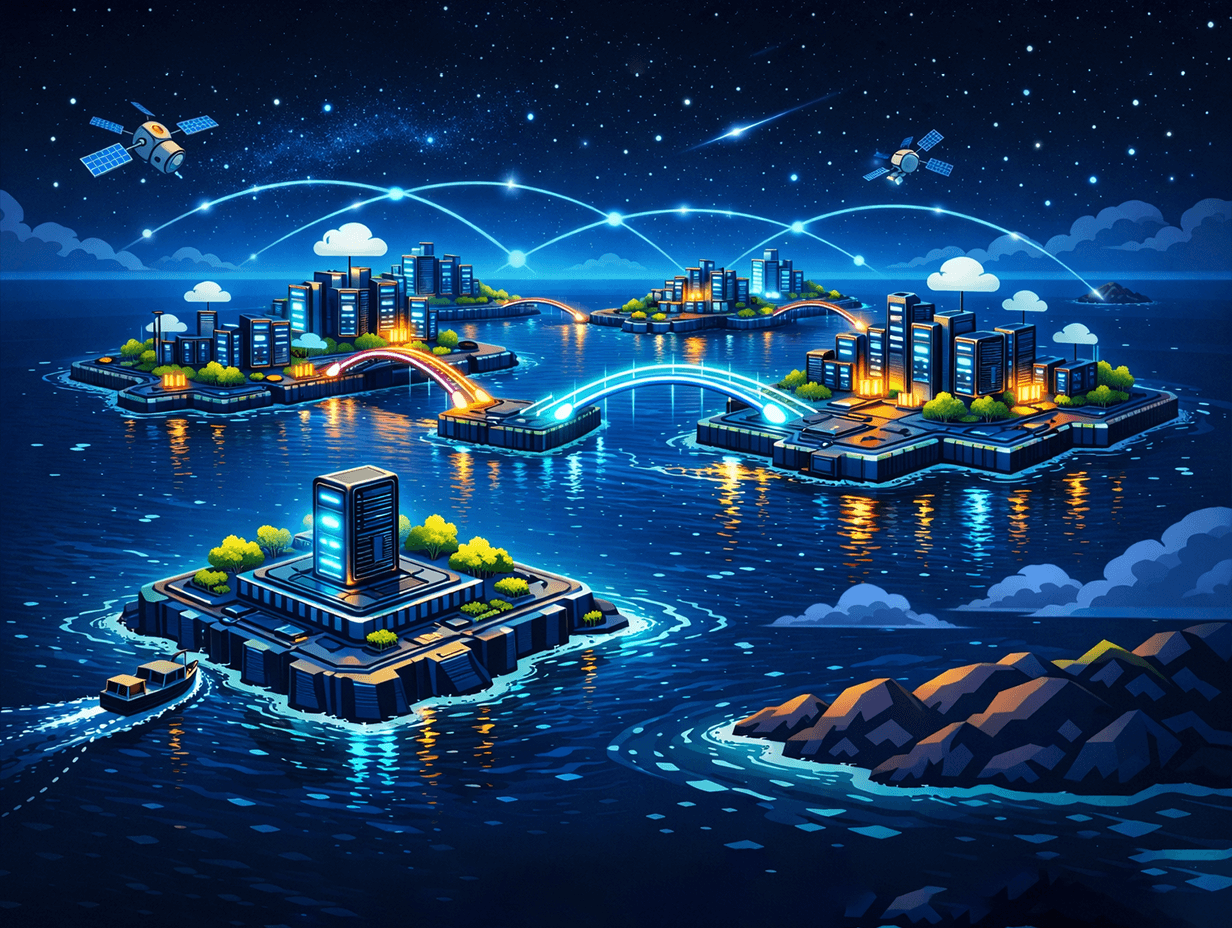

AI на всех облаках: как мультиоблачная стратегия даёт гибкость и отказоустойчивость

Мультиоблачная стратегия для AI помогает распределять хранение данных, обучение и инференс между разными провайдерами. Это повышает отказоустойчивость, снижает vendor lock-in, упрощает масштабирование по регионам и позволяет оптимизировать расходы.